In de afgelopen drie decennia is de manier waarop we muziek consumeren compleet veranderd. Met de komst van DSP's of digitale streamingdiensten zoals Spotify en Apple Music is audionormalisatie een essentieel onderdeel van het proces geworden.

Maar wat betekent het om audio te normaliseren? En hoe kun je je eigen digitale audiobestanden normaliseren? Hieronder vertellen we je precies hoe je audio normaliseert en waarom dit een belangrijke stap is bij het maken van moderne muziek.

Wat is audionormalisatie?

Wanneer je audio normaliseert, pas je een bepaalde hoeveelheid versterking toe op een digitaal audiobestand. Dit brengt je audiobestand naar een doel waargenomen amplitude of volumeniveau terwijl het dynamische bereik van de tracks behouden blijft.

Geluidsnormalisatie wordt gebruikt om het maximale volume uit een geselecteerde audioclip te halen. Het kan ook worden gebruikt om meer consistentie te creëren tussen meerdere audioclips. Je hebt bijvoorbeeld meerdere tracks binnen een album of EP.

Het is de moeite waard om op te merken dat nummers met een groter dynamisch bereik een grotere uitdaging kunnen vormen om effectief te normaliseren. Een piekamplitude kan bijvoorbeeld worden geplet of vervormd door het normalisatieproces.

Daarom moet elke audioclip anders worden benaderd als het aankomt op het normalisatieproces. Audionormalisatie is essentieel voor elke digitale opname, maar er is geen standaardaanpak die voor iedereen geschikt is.

Waarom zou je audio normaliseren?

Waarom is het dan belangrijk om je audiobestanden te normaliseren? Hier zijn een paar scenario's waarin het normaliseren van luidheid een must is:

Voorbereiding voor streamingdiensten

Streamingdiensten stellen een standaard normalisatieniveau in voor alle nummers in hun muziekbibliotheken. Op deze manier hoeven luisteraars het volume niet drastisch harder of zachter te zetten als ze van het ene nummer naar het andere overschakelen. Elk platform heeft een ander doelniveau, dus het is niet ongewoon om verschillende masters te hebben voor verschillende streamingplatforms.

De LUF's Loudness-doelen voor de populairste streamingdiensten zijn als volgt:

Spotify: -14 LUFS

Apple Muziek: -16 LUFS

Amazon Music: -9 tot -13 LUFS

Youtube: -13 tot -15 LUFS

Deezer: -14 tot -16 LUFS

CD: -9 LUFS

Soundcloud: -8 tot -13 LUFS

Elke ingenieur heeft zijn eigen filosofie bij het bepalen van het doelniveau voor elke master, maar deze standaardisaties moeten in acht worden genomen.

Maximaal volume bereiken

Geluidsnormalisatie kan worden gebruikt om de maximale versterking van elk audiobestand te bereiken. Dit kan ongelooflijk handig zijn bij het importeren van tracks in audiobewerkingssoftware of om een individueel audiobestand luider te maken.

Een consistent niveau creëren tussen verschillende audiobestanden

Je kunt audio ook normaliseren om meerdere audiobestanden op hetzelfde relatieve niveau in te stellen. Dit is vooral essentieel bij processen zoals gain staging, waarbij je audioniveaus instelt als voorbereiding op de volgende bewerkingsfase.

Je kunt ook audiobestanden normaliseren en bewerken na het afronden van een muziekproject zoals een album of EP. De sfeer en het geluid van de hele opname moeten redelijk consistent zijn, dus het kan zijn dat je terug moet gaan en de versterking moet aanpassen binnen de context van alle nummers.

De twee soorten audionormalisatie

Er zijn verschillende soorten audionormalisatie voor verschillende gebruikssituaties bij het opnemen van audio. Meestal komt het normaliseren van audio neer op pieknormalisatie en luidheidnormalisatie.

Pieknormalisatie

Pieknormalisatie is een lineair proces waarbij dezelfde hoeveelheid versterking wordt toegepast op een audiosignaal om een niveau te creëren dat consistent is met de piekamplitude van de audiotrack. Het dynamische bereik blijft hetzelfde en het nieuwe audiobestand klinkt min of meer hetzelfde, behalve dat de track verandert in een luider of stiller audiobestand.

Dit proces vindt de hoogste PCM-waarde of pulse-code modulation-waarde van een audiobestand. In principe verwerkt de pieknormalisatie audio op basis van de bovengrens van een digitaal audiosysteem, wat meestal neerkomt op het normaliseren van de maximale piek op 0 DBs.

Het normalisatie-effect door pieknormalisatie is strikt gebaseerd op piekniveaus in plaats van op het waargenomen volume van de track.

Luidheidsnormalisatie

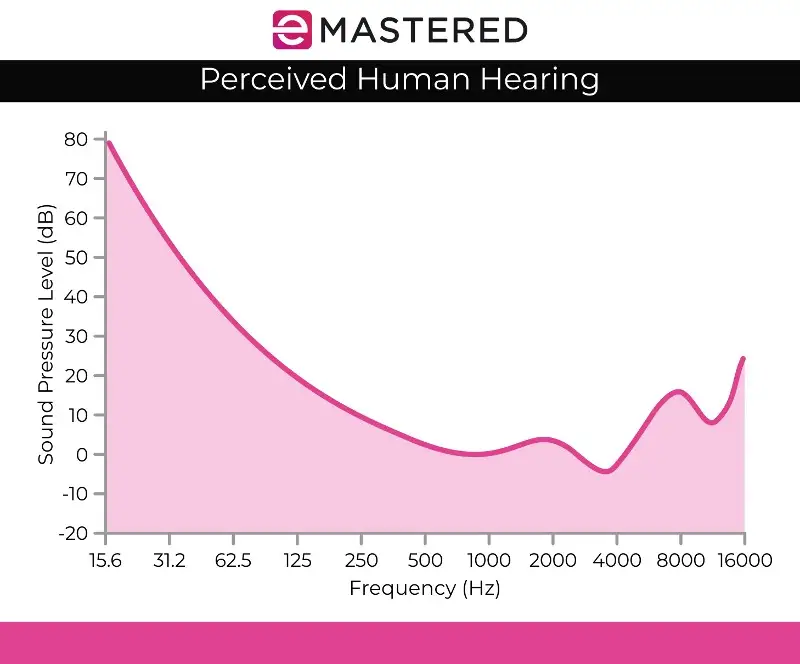

Het normalisatieproces voor luidheid is complexer omdat het rekening houdt met de menselijke waarneming van het gehoor. Het menselijk gehoor houdt afzonderlijk rekening met verschillende volumes en amplitude omdat het menselijk oor bepaalde subjectieve gebreken heeft als het gaat om waarneming. Deze verwerking wordt ook wel EBU R 128 volumedetectie genoemd.

Zo klinken geluiden die aanhouden op hetzelfde geluidsniveau als geluiden die vluchtig of kort worden afgespeeld automatisch luider. Je kunt deze geluiden op hetzelfde volumeniveau laten horen en het menselijk gehoor zou het aangehouden geluid nog steeds als luider waarnemen. Daarom moet luidheidsnormalisatie rekening houden met deze perceptuele afwijkingen.

Sommigen geloven ook dat hardere muziek beter klinkt. Dit heeft geleid tot de loudness wars voordat streamingdiensten bestonden, waarbij muzikanten probeerden om het piekvolume te maximaliseren om een sonisch aangenamer kunstwerk te produceren. Gelukkig heeft audionormalisatie effectief een einde gemaakt aan de loudness war, zodat je niet constant verschillende volumes hoort als je van het ene nummer naar het andere springt.

Luidheidsnormalisatie wordt gemeten in LUF's, wat meer overeenkomt met het menselijk oor en dient als de audiostandaard in toepassingen zoals film, tv, radio en streamingdiensten. Net als bij pieknormalisatie blijven 0 dB's de standaard.

De Fletcher Munson curve, zoals hierboven afgebeeld, kan helpen bij het beschrijven van de discrepanties waarmee rekening wordt gehouden bij LUFS-normalisatie van luidheid.

RMS Volumedetectie

Als je stereokanalen niet gaat normaliseren met piekniveaunormalisatie, zul je waarschijnlijk luidheidsnormalisatie gebruiken, maar het is nog steeds de moeite waard om de andere methode van luidheidsverwerking te noemen, namelijk RMS volumedetectie.

Het normalisatieproces is vergelijkbaar met LUF-normalisatie voor luidheid, maar in plaats daarvan worden RMS-niveaus gebruikt. Root Mean Square of RMS meet het gemiddelde volume van een gedeelte of de hele duur van een clip.

Maar net als normaliseren op basis van de hoogste piek, houdt RMS-normalisatie geen rekening met het menselijk gehoor. Daarom werken masteringtechnici meestal met LUF-luidheidseenheden en normalisatieprocessen als standaard. Mastering gaat niet alleen over het creëren van passende volumes voor een project. Het is ook belangrijk om een stapje terug te doen en rekening te houden met dynamiek, menselijke perceptie en balans tussen elke track.

Normalisatie vs. compressie: Wat is het verschil?

Vaak wordt gedacht dat normalisatie en compressie hetzelfde zijn, maar dit is een veel voorkomende misvatting. Compressie is ontworpen om het laagste volume van een track te verhogen en de pieken van een track te verlagen, zodat er meer consistente volumeniveaus ontstaan. Normalisatie daarentegen stelt het luidste instelpunt in als het plafond in je audiotrack.

Van daaruit wordt een evenredige hoeveelheid clipversterking toegepast op de rest van het geluid, waarbij de dynamiek (de afstand tussen de luidste en zachtste geluiden) behouden blijft en het waargenomen volume effectief wordt verhoogd, afhankelijk van het piekniveau.

De nadelen van audionormalisatie

Het is de moeite waard om op te merken dat er een aantal nadelen kleven aan het normaliseren van audio. Meestal normaliseer je audio alleen tijdens de laatste fasen van het creatieproces. Dit komt omdat normalisatie audio vaak naar de piekamplitude brengt binnen een digitaal plafond, dus je hebt niet veel bewerkingsmogelijkheden nadat een stuk audio is genormaliseerd.

Je zou geen individuele audiotracks willen normaliseren die nog gemixt moeten worden binnen de context van een multitrackopname. Als alle individuele componenten al zijn genormaliseerd naar je digitale audioplafond, zullen ze zeker gaan clippen als ze samen worden afgespeeld.

Audionormalisatie is van nature ook destructief. Wanneer je audio normaliseert, wordt de digitale verwerking in het audiospoor ingebakken. Daarom heeft audionormalisatie een duidelijke tijd en plaats. Dit proces wordt meestal gebruikt nadat je audiobestanden naar smaak zijn bewerkt.

Audio normaliseren

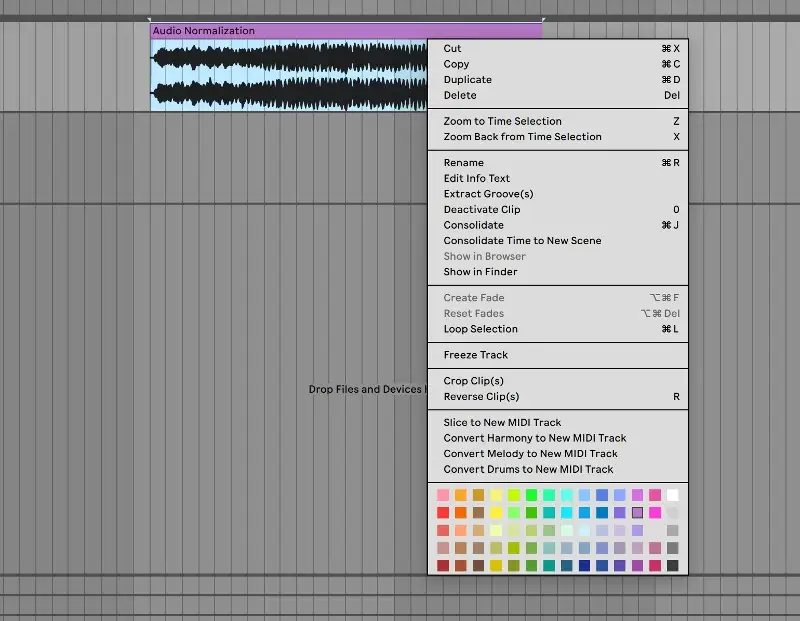

Elke DAW heeft zijn eigen manier om digitale audio te normaliseren. We zullen laten zien hoe je audio kunt normaliseren in Ableton Live, maar alle audiobewerkingssoftware heeft deze mogelijkheid ingebakken in de besturingselementen:

1. Consolideer je baan

Om te beginnen breng je je audiobestand naar een schone audiotrack. Selecteer het audiospoor, klik met de rechtermuisknop en selecteer "consolideren" in het menu. Je kunt ook de sneltoets CTRL/CMND + J gebruiken om snel een gemarkeerd spoor te consolideren.

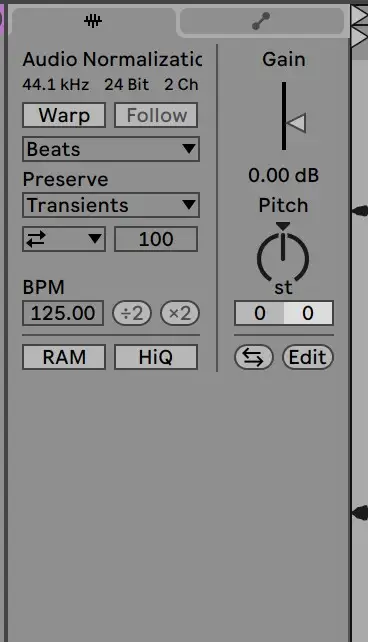

2. Warp uitschakelen en versterking terugzetten op 0 dB

Ga van daaruit naar de sampleclip om warp uit te schakelen en de gain terug te zetten naar 0 DB. Je kunt dit doen door te dubbelklikken op de gain-pijl:

3. Controleren aan de hand van het originele bestand

Vanaf dat punt zou je clip genormaliseerd moeten zijn! Je kunt de niveaus van je clip vergelijken met het originele audiobestand om er zeker van te zijn dat het correct is verwerkt.

Het normaliseren van audio is een essentiële vaardigheid voor elke producer. Hopelijk maakt deze gids het makkelijker voor je om te begrijpen hoe je tracks normaliseert en hoe belangrijk dit proces is.