Viimeisten kolmen vuosikymmenen aikana musiikin kulutustapa on muuttunut täysin. DSP:iden tai Spotifyn ja Apple Musicin kaltaisten digitaalisten suoratoistopalvelujen myötä äänen normalisoinnista on tullut olennainen osa prosessia.

Mutta mitä tarkoittaa äänen normalisointi? Ja miten voit normalisoida omat digitaaliset äänitiedostosi? Seuraavassa kerromme, miten äänitiedostojen normalisointi tehdään ja miksi se on tärkeä vaihe nykyaikaisessa musiikin tekemisessä.

Mikä on äänen normalisointi?

Kun normalisoit ääntä, digitaaliseen äänitiedostoon lisätään tietty määrä vahvistusta. Näin äänitiedosto saatetaan tavoitteelliseen amplitudiin tai äänenvoimakkuuteen säilyttäen raitojen dynaaminen alue.

Äänen normalisointia käytetään valitun äänileikkeen enimmäisäänenvoimakkuuden saavuttamiseksi. Sitä voidaan käyttää myös yhdenmukaisuuden lisäämiseen useiden äänileikkeiden välillä. Esimerkiksi albumin tai EP:n sisällä voi olla useita raitoja.

On syytä huomata, että kappaleet, joilla on suurempi dynaaminen alue, voi olla haastavampi normalisoida tehokkaasti. Esimerkiksi huippuamplitudi saattaa puristua tai vääristyä normalisointiprosessin aikana.

Siksi jokaista äänileikettä on lähestyttävä eri tavalla normalisointiprosessissa. Äänen normalisointi on olennaisen tärkeää kaikissa digitaalisissa tallenteissa, mutta kaikille sopivaa lähestymistapaa ei ole olemassa.

Miksi sinun pitäisi normalisoida ääni?

Miksi äänitiedostojen normalisointi on tärkeää? Seuraavassa on muutamia tilanteita, joissa äänenvoimakkuuden normalisointi on välttämätöntä:

Valmistautuminen suoratoistopalveluihin

Suoratoistopalvelut asettavat musiikkikirjastoissaan oleville kappaleille vakionormalisointitason. Näin kuuntelijoiden ei tarvitse nostaa tai laskea äänenvoimakkuutta rajusti vaihtaessaan kappaleesta toiseen. Jokaisella alustalla on erilainen tavoitetaso, joten ei ole harvinaista, että eri suoratoistoalustoilla on erilaisia mastereita.

Suosituimpien suoratoistopalveluiden LUFs Loudness-tavoitteet ovat seuraavat:

Spotify: LUFS: -14 LUFS

Apple Music: -16 LUFS

Amazon Music: -9 - -13 LUFS

Youtube: -13 - -15 LUFS

Deezer: -14 - -16 LUFS-yksikköä.

CD: -9 LUFS

Soundcloud: -8 - -13 LUFS

Jokaisella insinöörillä on oma filosofiansa määritettäessä tavoitetasoa kullekin päällikölle, mutta nämä standardoinnit olisi otettava huomioon.

Maksimivolyymin saavuttaminen

Äänen normalisoinnilla voidaan saavuttaa kunkin äänitiedoston maksimaalinen vahvistus. Tämä voi olla erittäin hyödyllistä, kun tuot raitoja audioeditointiohjelmistoon tai kun haluat tehdä yksittäisestä äänitiedostosta äänekkäämmän.

Luo yhdenmukainen taso useiden äänitiedostojen välille

Voit myös normalisoida äänen asettamalla useita äänitiedostoja samalle suhteelliselle tasolle. Tämä on erityisen tärkeää prosesseissa, kuten gain staging -prosessissa, jossa äänitasot asetetaan seuraavaa käsittelyvaihetta varten.

Voit myös normalisoida ja muokata äänitiedostoja, kun saat valmiiksi musiikkiprojektin, kuten albumin tai EP:n. Koko äänityksen ilmapiirin ja äänen pitäisi olla melko yhtenäinen läpi koko äänityksen, joten saatat joutua palaamaan takaisin ja säätämään vahvistusta kaikkien kappaleiden yhteydessä.

Äänen normalisoinnin kaksi tyyppiä

Äänen normalisoinnissa on erilaisia tyyppejä eri äänitallennuskäyttötapauksia varten. Useimmiten äänen normalisoinnissa on kyse äänihuippujen normalisoinnista ja äänenvoimakkuuden normalisoinnista.

Huipun normalisointi

Huipun normalisointi on lineaarinen prosessi, jossa sama määrä vahvistusta sovelletaan audiosignaaliin, jotta saadaan aikaan ääniraidan huippuamplitudin mukainen taso. Dynaaminen alue pysyy samana, ja uusi äänitiedosto kuulostaa suunnilleen samalta lukuun ottamatta raidan muuttumista äänekkäämmäksi tai hiljaisemmaksi äänitiedostoksi.

Tämä prosessi löytää äänitiedoston korkeimman PCM-arvon tai pulssikoodimodulaatioarvon. Periaatteessa huippuarvon normalisointi käsittelee ääntä digitaalisen äänijärjestelmän ylärajan perusteella, mikä yleensä vastaa maksimihuipun normalisointia 0 DB:hen.

Huippunormalisoinnin avulla tapahtuva normalisointi perustuu tiukasti huipputasoihin eikä kappaleen havaittuun äänenvoimakkuuteen.

Äänenvoimakkuuden normalisointi

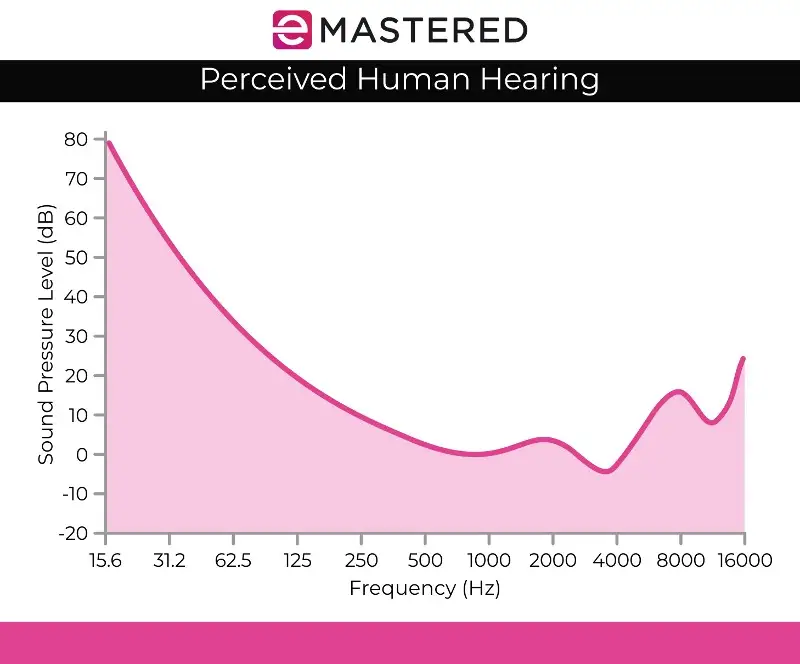

Äänenvoimakkuuden normalisointiprosessi on monimutkaisempi, koska siinä otetaan huomioon ihmisen kuulohavainto. Ihmisen kuulo ottaa huomioon eri äänenvoimakkuudet ja amplitudit erikseen, koska ihmiskorvalla on tiettyjä subjektiivisia puutteita havaitsemisessa. Saatat kuulla, että tähän käsittelyyn viitataan nimellä EBU R 128 -äänenvoimakkuuden tunnistus.

Esimerkiksi äänet, jotka pysyvät samalla äänitasolla kuin ohimenevästi tai lyhyesti toistetut äänet, kuulostavat automaattisesti kovemmilta. Nämä äänet voidaan toistaa samalla äänenvoimakkuudella, ja ihmisen kuulo havaitsee silti jatkuvan äänen kovempana. Äänenvoimakkuuden normalisoinnissa on siis otettava huomioon nämä havaintomuutokset.

Jotkut uskovat myös, että kovempi musiikki kuulostaa yleensä paremmalta. Tämä synnytti ennen suoratoistopalveluiden olemassaoloa äänekkyyssodat, joissa muusikot yrittivät maksimoida huippuvolyymin tuottaakseen äänellisesti miellyttävämmän taideteoksen. Onneksi äänen normalisointi on tehokkaasti lopettanut äänekkyyssodan, joten et kuule jatkuvasti erilaisia äänenvoimakkuuksia, kun hyppäät kappaleesta toiseen.

Äänenvoimakkuuden normalisointi mitataan LUF-yksikköinä, jotka vastaavat paremmin ihmiskorvan äänentuntemusta ja toimivat äänistandardeina esimerkiksi elokuvissa, televisiossa, radiossa ja suoratoistopalveluissa. Aivan kuten huipun normalisoinnissa, 0 dBs on edelleen standardi.

Yllä kuvattu Fletcher Munsonin käyrä voi auttaa kuvaamaan LUFS-äänenvoimakkuuden normalisoinnissa huomioon otettuja eroja.

RMS-äänenvoimakkuuden havaitseminen

Jos et aio normalisoida stereokanavia huipputason normalisoinnilla, käytät todennäköisesti äänenvoimakkuuden normalisointia, mutta on silti syytä mainita toinen äänenvoimakkuuden käsittelymenetelmä, joka on RMS-volyymin tunnistus.

Normalisointiprosessi on samankaltainen kuin LUF:n äänenvoimakkuuden normalisointi, mutta siinä käytetään RMS-tasoja. Root Mean Square eli RMS mittaa jakson tai leikkeen koko keston keskimääräistä äänenvoimakkuutta.

Aivan kuten korkeimpaan huippuun perustuva normalisointi, myös RMS-normalisointi ei kuitenkaan ota huomioon ihmisen korvaa. Tämän vuoksi masterointi-insinöörit työskentelevät yleensä LUF-äänenvoimakkuusyksiköiden ja normalisointiprosessien kanssa standardina. Mastering ei ole vain yhteensopivien äänenvoimakkuuksien luomista koko projektissa. On myös tärkeää ottaa askel taaksepäin ja pohtia dynamiikkaa, ihmisen havaintokykyä ja tasapainoa kunkin raidan välillä.

Normalisointi vs. pakkaaminen: Mikä on ero?

Usein normalisoinnin ja pakkauksen ajatellaan olevan sama asia, mutta tämä on yleinen väärinkäsitys. Kompressio on suunniteltu nostamaan raidan alhaisinta äänenvoimakkuutta ja laskemaan raidan huippuja, jolloin saadaan aikaan yhtenäisempi äänenvoimakkuus. Normalisointi sen sijaan asettaa ääniraidan kovimman asetetun pisteen ylärajaksi.

Siitä lähtien muuhun äänitilaan sovelletaan suhteutettua clip-vahvistusta, jolloin dynamiikka (äänekkäimpien ja hiljaisimpien äänien välinen etäisyys) säilyy, mikä lisää tehokkaasti havaittavaa äänenvoimakkuutta huipputason mukaan.

Äänen normalisoinnin varjopuolet

On syytä huomata, että äänen normalisoinnissa on joitakin haittoja. Useimmiten ääni normalisoidaan vasta luomisprosessin loppuvaiheessa. Tämä johtuu siitä, että normalisointi tuo usein äänen huippuamplitudin digitaaliseen kattoon, joten sinulla ei ole paljon muokkausmahdollisuuksia sen jälkeen, kun äänikappale on normalisoitu.

Et halua normalisoida yksittäisiä ääniraitoja, jotka on vielä miksattava moniraitaäänityksen yhteydessä. Jos kaikki yksittäiset komponentit on jo normalisoitu digitaalisen äänikattosi mukaan, ne varmasti leikataan, kun ne soitetaan yhdessä.

Äänen normalisointi on myös luonteeltaan tuhoavaa. Kun ääni normalisoidaan, digitaalinen prosessointi sisällytetään ääniraitaan. Siksi äänen normalisoinnilla on selkeä aika ja paikka. Tätä prosessia käytetään useimmiten sen jälkeen, kun äänitiedostot on käsitelty maun mukaan.

Kuinka normalisoida ääni

Jokaisella DAW:llä on oma tapansa normalisoida digitaalinen ääni. Esittelemme, miten voit normalisoida ääntä Ableton Livessä, mutta kaikissa äänenmuokkausohjelmissa tämä ominaisuus on sisällytetty niiden säätimiin:

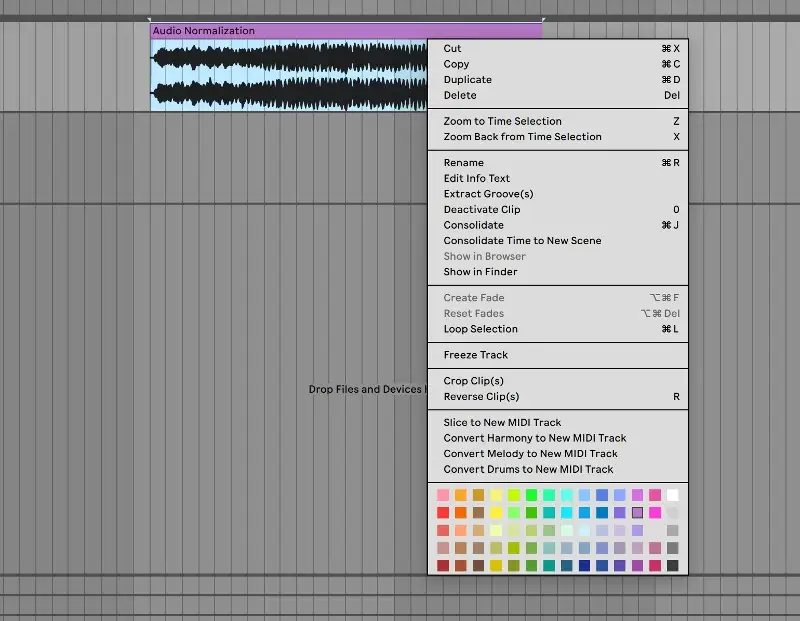

1. Konsolidoi raiteesi

Aloita tuomalla äänitiedostosi puhtaalle ääniraidalle. Valitse ääniraita, napsauta hiiren kakkospainikkeella ja valitse valikosta "konsolidoi". Voit myös käyttää pikanäppäintä CTRL/CMND + J konsolidoidaksesi nopeasti korostetun raidan.

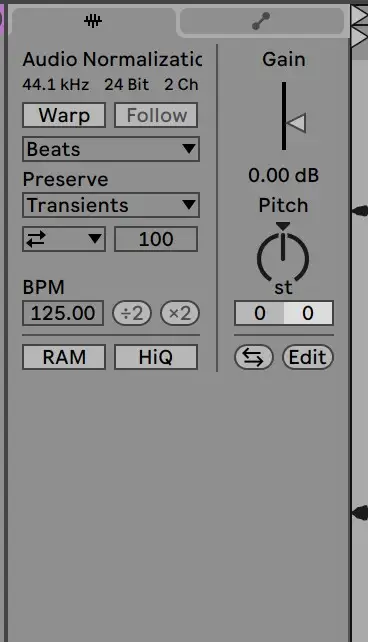

2. Poista poimu käytöstä ja palauta vahvistus 0 dB:iin.

Siirry sieltä näyteleikkeeseen poistaaksesi poimun käytöstä ja nollataksesi vahvistuksen 0 DB:hen. Voit tehdä tämän kaksoisnapsauttamalla gain-nuolta:

3. Tarkista alkuperäisestä tiedostosta

Siitä leikkeesi pitäisi olla normalisoitu! Voit tarkistaa klippisi tasot alkuperäisestä äänitiedostosta varmistaaksesi, että se on käsitelty oikein.

Äänen normalisointi on olennainen taito jokaiselle tuottajalle. Toivottavasti tämä opas helpottaa sinua ymmärtämään, miten kappaleesi normalisoidaan ja miten tärkeää tämä prosessi on.