Nas últimas três décadas, a realidade de como consumimos música mudou completamente. Com o advento dos DSPs ou dos serviços de streaming digital, como o Spotify e o Apple Music, a normalização do áudio tornou-se uma parte essencial do processo.

Mas o que é que significa normalizar o áudio? E como pode normalizar os seus próprios ficheiros de áudio digital? Abaixo, vamos partilhar exatamente como normalizar o áudio e porque é que é um passo fundamental na criação de música moderna.

O que é a normalização de áudio?

Quando normaliza o áudio, está a aplicar uma certa quantidade de ganho a um ficheiro de áudio digital. Isto faz com que o ficheiro de áudio atinja uma amplitude ou nível de volume percebido, preservando a gama dinâmica das faixas.

A normalização de áudio é utilizada para obter o volume máximo de um clip de áudio selecionado. Também pode ser utilizada para criar mais consistência em vários clips de áudio. Por exemplo, pode ter várias faixas dentro de um álbum ou EP.

É importante notar que as músicas com uma gama dinâmica maior podem ser mais difíceis de normalizar eficazmente. Por exemplo, uma amplitude de pico pode ficar esmagada ou distorcida durante o processo de normalização.

Por conseguinte, cada clip de áudio deve ser abordado de forma diferente no que diz respeito ao processo de normalização. A normalização de áudio é essencial para qualquer gravação digital, mas não existe uma abordagem única para todos.

Porque é que se deve normalizar o áudio?

Então, porque é que é importante normalizar os seus ficheiros de áudio? Aqui estão alguns cenários em que a normalização da intensidade do som é uma necessidade:

Preparação para serviços de streaming

Os serviços de streaming definem um nível de normalização padrão para as músicas alojadas nas suas bibliotecas de música. Desta forma, os ouvintes não terão de aumentar ou diminuir drasticamente o volume quando mudam de uma música para outra. Cada plataforma tem um nível-alvo diferente, pelo que não é invulgar existirem diferentes masters para várias plataformas de streaming.

Os objectivos de intensidade LUFs para os serviços de streaming mais populares são os seguintes

Spotify: -14 LUFS

Apple Music: -16 LUFS

Amazon Music: -9 a -13 LUFS

Youtube: -13 a -15 LUFS

Deezer: -14 a -16 LUFS

CD: -9 LUFS

Soundcloud: -8 a -13 LUFS

Cada engenheiro tem a sua própria filosofia quando se trata de determinar o nível alvo para cada mestre, mas estas normalizações devem ser tidas em conta.

Atingir o volume máximo

A normalização de áudio pode ser utilizada para obter o ganho máximo de cada ficheiro de áudio. Isto pode ser incrivelmente útil durante a importação de faixas para o software de edição de áudio ou para tornar um ficheiro de áudio individual mais alto.

Criar um nível consistente entre vários ficheiros de áudio

Também é possível normalizar o áudio para definir vários ficheiros de áudio no mesmo nível relativo. Isto é particularmente essencial em processos como a preparação de ganho, onde define os níveis de áudio em preparação para a fase seguinte do processamento.

Também pode normalizar e editar ficheiros de áudio ao concluir um projeto musical como um álbum ou um EP. Toda a atmosfera e som da gravação devem ser bastante consistentes, pelo que poderá ter de voltar atrás e ajustar o ganho no contexto de todas as canções.

Os dois tipos de normalização de áudio

Existem diferentes tipos de normalização de áudio para vários casos de uso de gravação de áudio. Na maioria das vezes, a normalização de áudio se resume à normalização de pico e à normalização de volume.

Normalização de picos

A normalização de picos é um processo linear em que a mesma quantidade de ganho é aplicada a um sinal de áudio para criar um nível consistente com a amplitude de pico da faixa de áudio. A gama dinâmica permanece a mesma, e o novo ficheiro de áudio soa mais ou menos da mesma forma, sem que a faixa se transforme num ficheiro de áudio mais alto ou mais baixo.

Este processo encontra o valor PCM ou o valor de modulação de código de pulso mais elevado de um ficheiro de áudio. Basicamente, a normalização de pico processa o áudio com base no limite superior de um sistema de áudio digital, o que normalmente equivale a normalizar o pico máximo em 0 DBs.

O efeito de normalização através da normalização de pico baseia-se estritamente nos níveis de pico, em vez do volume percepcionado da faixa.

Normalização da intensidade do som

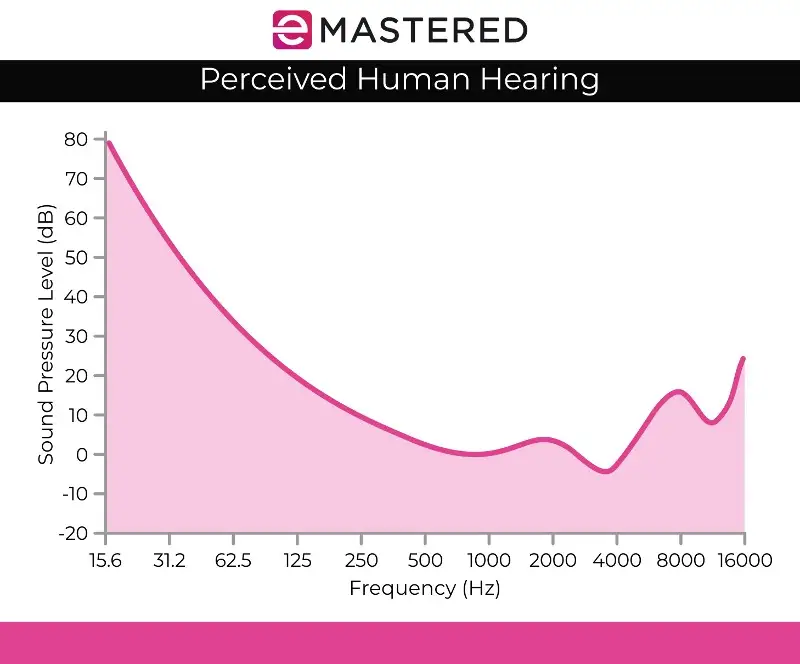

O processo de normalização do volume é mais complexo, uma vez que tem em conta a perceção humana da audição. A audição humana considera diferentes volumes e amplitudes separadamente, uma vez que o ouvido humano tem certas falhas subjectivas no que diz respeito à perceção. Poderá ouvir este processamento ser referido como deteção de volume EBU R 128.

Por exemplo, os sons que são mantidos ao mesmo nível de áudio que os sons que são reproduzidos de forma transitória ou breve soam automaticamente mais altos. Pode emitir estes sons ao mesmo nível de volume, e a audição humana continuaria a percecionar o som sustentado como mais alto. Assim, a normalização da sonoridade tem de ter em conta estes desvios perceptivos.

Há também quem acredite que a música mais alta tende a soar melhor. Foi isto que deu origem às guerras de volume antes da existência dos serviços de streaming, em que os músicos tentavam maximizar o volume máximo para produzir uma obra de arte mais agradável em termos sonoros. Felizmente, a normalização do áudio acabou com a guerra do volume, para que não se ouça constantemente volumes diferentes quando se passa de uma faixa para a seguinte.

A normalização da intensidade do som é medida em LUFs, o que é mais fiel ao ouvido humano e serve como padrão de áudio em aplicações como filmes, TV, rádio e serviços de streaming. Assim como a normalização de pico, 0 dBs continua sendo o padrão.

A curva de Fletcher Munson, tal como representada acima, pode ajudar a descrever as discrepâncias tidas em conta com a normalização da sonoridade LUFS.

Deteção de volume RMS

Se não vai normalizar os canais estéreo com a normalização do nível de pico, é provável que utilize a normalização do volume, mas vale a pena mencionar o outro método de processamento do volume, que é a deteção do volume RMS.

O processo de normalização é semelhante à normalização de sonoridade do LUF, mas utiliza níveis RMS. O Root Mean Square ou RMS mede o volume médio de uma secção ou de toda a duração de um clip.

No entanto, assim como a normalização baseada no pico mais alto, a normalização RMS não leva em conta a audição humana. É por isso que os engenheiros de masterização normalmente trabalham com unidades de loudness LUFs e processos de normalização como um padrão. A masterização não é apenas a criação de volumes correspondentes ao longo de um projeto. Também é fundamental dar um passo atrás e considerar a dinâmica, a perceção humana e o equilíbrio entre cada faixa.

Normalização vs. Compressão: Qual é a diferença?

Muitas vezes, pensa-se que a normalização e a compressão são a mesma coisa, mas este é um equívoco comum. A compressão foi concebida para aumentar o volume mais baixo de uma faixa e diminuir os picos de uma faixa, criando níveis de volume mais consistentes em geral. Em contrapartida, a normalização define o ponto de ajuste mais alto como o teto da sua faixa de áudio.

A partir daí, uma quantidade proporcional de ganho de clipe é aplicada ao resto do áudio, preservando a dinâmica (a distância entre os sons mais altos e mais baixos), aumentando efetivamente o volume percebido, dependendo do nível de pico.

As desvantagens da normalização de áudio

É importante notar que existem algumas desvantagens na normalização do áudio. Na maioria das vezes, só se normaliza o áudio durante as fases finais do processo de criação. Isto deve-se ao facto de a normalização levar frequentemente o áudio ao pico de amplitude dentro de um teto digital, pelo que não tem muito poder de edição depois de uma peça de áudio ter sido normalizada.

Não é aconselhável normalizar faixas de áudio individuais que ainda precisam de ser misturadas no contexto de uma gravação multipista. Se todos os componentes individuais já estiverem normalizados para o seu teto de áudio digital, irão certamente cortar quando forem reproduzidos em conjunto.

A normalização de áudio também é destrutiva por natureza. Quando se normaliza o áudio, o processamento digital é incorporado na faixa de áudio. Portanto, a normalização de áudio tem um tempo e um lugar claros. Este processo é utilizado principalmente depois de os ficheiros de áudio terem sido processados a gosto.

Como normalizar o áudio

Cada DAW tem a sua própria forma de normalizar o áudio digital. Iremos mostrar como pode normalizar o áudio no Ableton Live, mas todos os softwares de edição de áudio têm esta capacidade incorporada nos seus controlos:

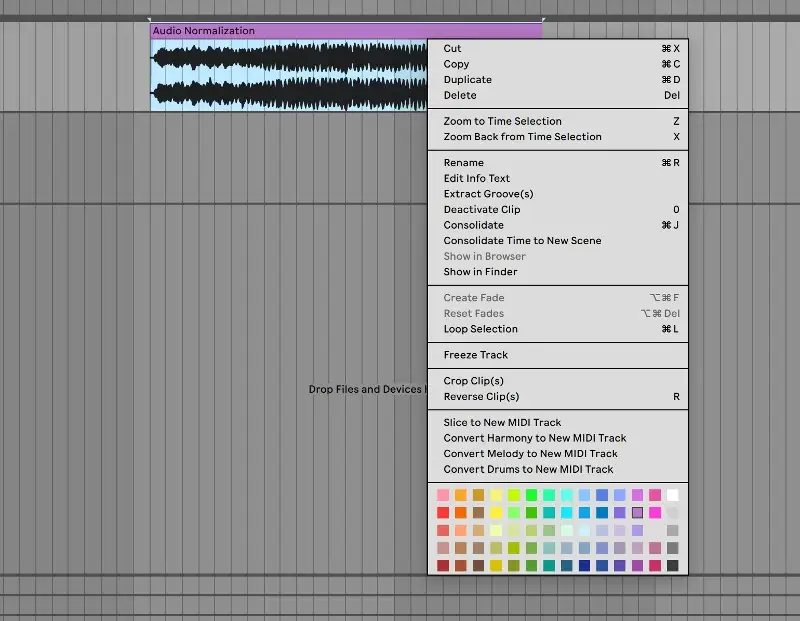

1. Consolidar o seu percurso

Para começar, traga o seu ficheiro de áudio para uma faixa de áudio limpa. Seleccione a faixa de áudio, clique com o botão direito do rato e seleccione "consolidar" no menu. Também pode utilizar o atalho de teclado CTRL/CMND + J para consolidar rapidamente uma faixa destacada.

2. Desativar a distorção e repor o ganho a 0 dB

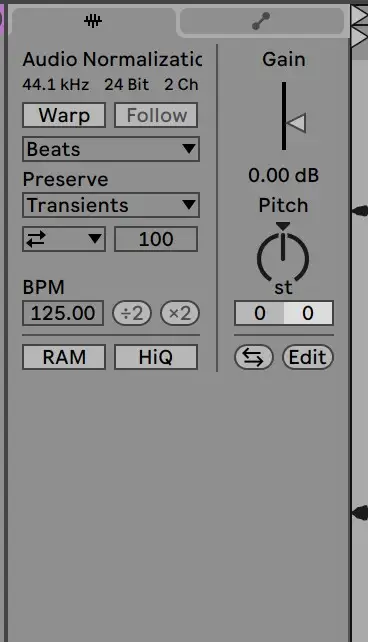

A partir daí, vá para o clip de amostra para desativar a distorção e repor o ganho para 0 DB. Para tal, basta fazer duplo clique na seta de ganho:

3. Verificar com o ficheiro original

A partir daí, o seu clip deve estar normalizado! Pode verificar os níveis do seu clip em relação ao ficheiro de áudio original para se certificar de que foi processado corretamente.

Normalizar o áudio é uma habilidade essencial para qualquer produtor. Esperamos que este guia facilite a compreensão exacta de como normalizar as suas faixas e a importância deste processo.