W ciągu ostatnich trzech dekad rzeczywistość tego, jak konsumujemy muzykę, całkowicie się zmieniła. Wraz z pojawieniem się procesorów DSP lub cyfrowych usług strumieniowych, takich jak Spotify i Apple Music, normalizacja dźwięku stała się istotną częścią tego procesu.

Ale co to znaczy normalizować dźwięk? I jak można znormalizować własne cyfrowe pliki audio? Poniżej przedstawiamy, jak dokładnie normalizować dźwięk i dlaczego jest to kluczowy krok w nowoczesnym tworzeniu muzyki.

Czym jest normalizacja dźwięku?

Normalizacja dźwięku polega na zastosowaniu pewnej ilości wzmocnienia do cyfrowego pliku audio. Powoduje to doprowadzenie pliku audio do docelowego postrzeganego poziomu amplitudy lub głośności przy jednoczesnym zachowaniu zakresu dynamiki ścieżek.

Normalizacja dźwięku służy do uzyskania maksymalnej głośności z wybranego klipu audio. Może być również używana do tworzenia większej spójności między wieloma klipami audio. Na przykład, możesz mieć wiele ścieżek w albumie lub EP.

Warto zauważyć, że utwory o większym zakresie dynamiki mogą być trudniejsze do skutecznej normalizacji. Na przykład amplituda szczytowa może zostać zgnieciona lub zniekształcona w procesie normalizacji.

Dlatego też do każdego klipu audio należy podejść inaczej, jeśli chodzi o proces normalizacji. Normalizacja dźwięku jest niezbędna dla każdego nagrania cyfrowego, ale nie ma jednego uniwersalnego podejścia.

Dlaczego warto normalizować dźwięk?

Dlaczego więc normalizacja plików audio jest tak ważna? Oto kilka scenariuszy, w których normalizacja głośności jest koniecznością:

Przygotowanie do usług streamingowych

Usługi streamingowe ustalają standardowy poziom normalizacji dla wszystkich utworów znajdujących się w ich bibliotekach muzycznych. W ten sposób słuchacze nie będą musieli drastycznie zwiększać lub zmniejszać głośności podczas przełączania się z jednego utworu na inny. Każda platforma ma inny poziom docelowy, więc nie jest niczym niezwykłym posiadanie różnych masterów dla różnych platform streamingowych.

Wartości docelowe głośności LUFs dla najpopularniejszych serwisów streamingowych są następujące:

Spotify: -14 LUFS

Apple Music: -16 LUFS

Amazon Music: -9 do -13 LUFS

Youtube: -13 do -15 LUFS

Deezer: -14 do -16 LUFS

CD: -9 LUFS

Soundcloud: -8 do -13 LUFS

Każdy inżynier ma swoją własną filozofię, jeśli chodzi o określanie docelowego poziomu dla każdego mastera, ale te standaryzacje powinny być brane pod uwagę.

Osiągnięcie maksymalnej objętości

Normalizacja dźwięku może być wykorzystana do osiągnięcia maksymalnego wzmocnienia każdego pliku audio. Może to być niezwykle przydatne podczas importowania ścieżek do oprogramowania do edycji dźwięku lub w celu zwiększenia głośności pojedynczego pliku audio.

Tworzenie spójnego poziomu pomiędzy kilkoma plikami audio

Można również normalizować dźwięk, aby ustawić wiele plików audio na tym samym względnym poziomie. Jest to szczególnie istotne w procesach takich jak gain staging, gdzie ustawia się poziomy audio w ramach przygotowań do następnego etapu przetwarzania.

Możesz także normalizować i edytować pliki audio po ukończeniu projektu muzycznego, takiego jak album lub EP. Cała atmosfera nagrania i dźwięk powinny być dość spójne, więc może być konieczne cofnięcie się i dostosowanie wzmocnienia w kontekście wszystkich utworów.

Dwa rodzaje normalizacji dźwięku

Istnieją różne rodzaje normalizacji dźwięku dla różnych przypadków użycia nagrywania dźwięku. W większości przypadków normalizacja dźwięku sprowadza się do normalizacji wartości szczytowych i normalizacji głośności.

Normalizacja wartości szczytowych

Normalizacja szczytowa jest procesem liniowym, w którym ta sama ilość wzmocnienia jest stosowana do sygnału audio w celu uzyskania poziomu zgodnego z amplitudą szczytową ścieżki audio. Zakres dynamiki pozostaje taki sam, a nowy plik audio brzmi mniej więcej tak samo poza ścieżką przekształcającą się w głośniejszy lub cichszy plik audio.

Proces ten znajduje najwyższą wartość PCM lub wartość modulacji kodu impulsowego pliku audio. Zasadniczo, normalizacja szczytowa przetwarza dźwięk w oparciu o górną granicę cyfrowego systemu audio, co zwykle równa się normalizacji maksymalnej wartości szczytowej na poziomie 0 DB.

Efekt normalizacji poprzez normalizację szczytową jest ściśle oparty na poziomach szczytowych, a nie na postrzeganej głośności ścieżki.

Normalizacja głośności

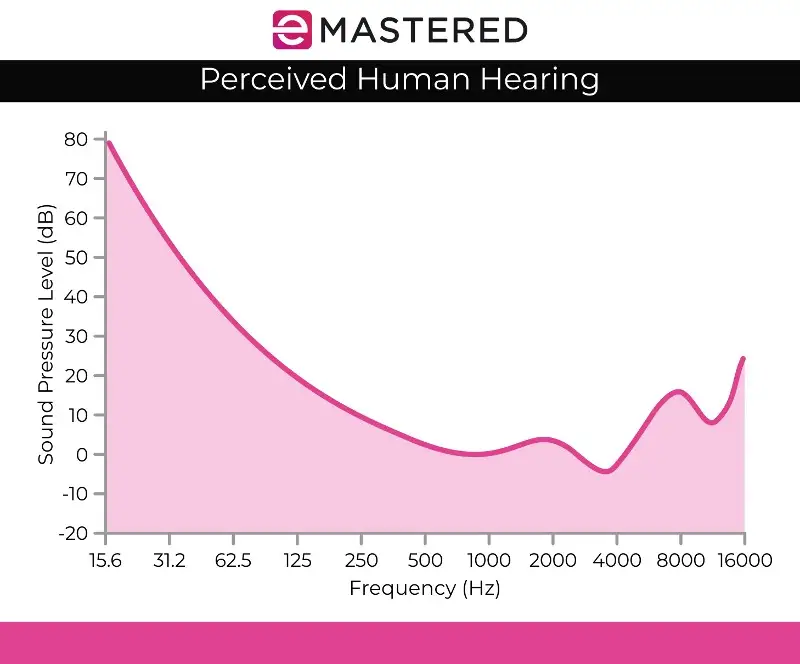

Proces normalizacji głośności jest bardziej złożony, ponieważ uwzględnia ludzką percepcję słuchu. Ludzki słuch uwzględnia różne głośności i amplitudy oddzielnie, ponieważ ludzkie ucho ma pewne subiektywne wady, jeśli chodzi o percepcję. Przetwarzanie to może być określane jako wykrywanie głośności EBU R 128.

Na przykład, dźwięki utrzymujące się na tym samym poziomie audio, co dźwięki odtwarzane przejściowo lub krótko, automatycznie brzmią głośniej. Można emitować te dźwięki na tym samym poziomie głośności, a ludzki słuch nadal będzie odbierał trwały dźwięk jako głośniejszy. Dlatego normalizacja głośności musi uwzględniać te przesunięcia percepcyjne.

Niektórzy uważają również, że głośniejsza muzyka brzmi lepiej. To właśnie zrodziło wojny o głośność przed istnieniem usług streamingowych, w których muzycy starali się zmaksymalizować głośność szczytową, aby stworzyć bardziej przyjemne dźwiękowo dzieło sztuki. Na szczęście normalizacja dźwięku skutecznie zakończyła wojnę głośności, dzięki czemu nie słyszysz ciągle różnych głośności podczas przeskakiwania z jednego utworu do drugiego.

Normalizacja głośności jest mierzona w LUF, co jest bardziej zgodne z ludzkim uchem i służy jako standard audio w aplikacjach takich jak filmy, telewizja, radio i usługi przesyłania strumieniowego. Podobnie jak w przypadku normalizacji szczytowej, standardem pozostaje 0 dB.

Krzywa Fletchera Munsona, jak pokazano powyżej, może pomóc opisać rozbieżności uwzględnione w normalizacji głośności LUFS.

Wykrywanie głośności RMS

Jeśli nie zamierzasz normalizować kanałów stereo za pomocą normalizacji poziomu szczytowego, prawdopodobnie użyjesz normalizacji głośności, ale nadal warto wspomnieć o innej metodzie przetwarzania głośności, którą jest wykrywanie głośności RMS.

Proces normalizacji jest podobny do normalizacji głośności LUF, ale zamiast tego wykorzystuje poziomy RMS. Root Mean Square lub RMS mierzy średnią głośność sekcji lub całego czasu trwania klipu.

Jednakże, podobnie jak normalizacja oparta na najwyższym szczycie, normalizacja RMS nie uwzględnia ludzkiego słuchu. Dlatego też inżynierowie masteringu zazwyczaj pracują z jednostkami głośności LUF i procesami normalizacji jako standardem. Mastering to nie tylko tworzenie dopasowanych głośności w całym projekcie. Kluczowe jest również cofnięcie się i rozważenie dynamiki, ludzkiej percepcji i równowagi między każdą ścieżką.

Normalizacja a kompresja: Jaka jest różnica?

Wiele razy normalizacja i kompresja są uważane za to samo, ale jest to powszechne nieporozumienie. Kompresja ma na celu podniesienie najniższej głośności ścieżki i obniżenie szczytów ścieżki, tworząc bardziej spójne poziomy głośności. W przeciwieństwie do tego, normalizacja ustawia najgłośniejszy punkt jako sufit na ścieżce audio.

Stamtąd proporcjonalna ilość wzmocnienia klipu jest stosowana do reszty dźwięku, zachowując dynamikę (odległość między najgłośniejszymi i najcichszymi dźwiękami), skutecznie zwiększając postrzeganą głośność w zależności od poziomu szczytowego.

Wady normalizacji dźwięku

Warto zauważyć, że normalizacja dźwięku ma pewne wady. W większości przypadków normalizacja dźwięku odbywa się tylko na końcowych etapach procesu tworzenia. Wynika to z faktu, że normalizacja często doprowadza dźwięk do szczytowej amplitudy w suficie cyfrowym, więc nie masz zbyt wielu możliwości edycji po znormalizowaniu dźwięku.

Nie warto normalizować poszczególnych ścieżek audio, które nadal muszą być miksowane w kontekście nagrania wielościeżkowego. Jeśli wszystkie poszczególne komponenty są już znormalizowane do cyfrowego pułapu audio, z pewnością będą się przycinać podczas odtwarzania razem.

Normalizacja dźwięku jest również z natury destrukcyjna. Podczas normalizacji dźwięku przetwarzanie cyfrowe jest wbudowane w ścieżkę audio. Dlatego normalizacja dźwięku ma wyraźny czas i miejsce. Proces ten jest najczęściej używany po przetworzeniu plików audio do smaku.

Jak znormalizować dźwięk

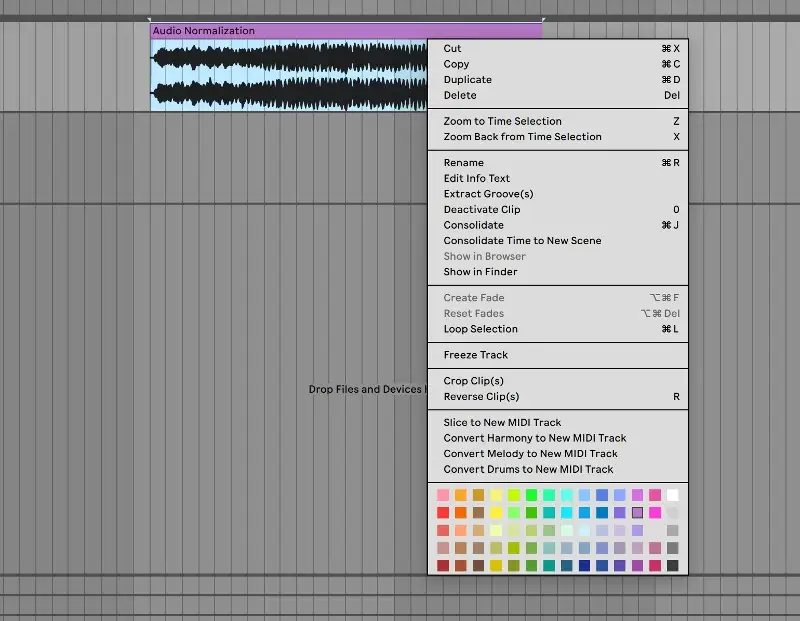

Każdy DAW ma swój własny sposób normalizacji cyfrowego dźwięku. Zaprezentujemy, w jaki sposób można normalizować dźwięk w Ableton Live, ale wszystkie programy do edycji dźwięku mają tę funkcję wbudowaną w swoje elementy sterujące:

1. Skonsoliduj swoją ścieżkę

Aby rozpocząć, przenieś plik audio na czystą ścieżkę audio. Wybierz ścieżkę audio, kliknij prawym przyciskiem myszy i wybierz "konsoliduj" z menu. Możesz także użyć skrótu klawiaturowego CTRL/CMND + J, aby szybko skonsolidować podświetloną ścieżkę.

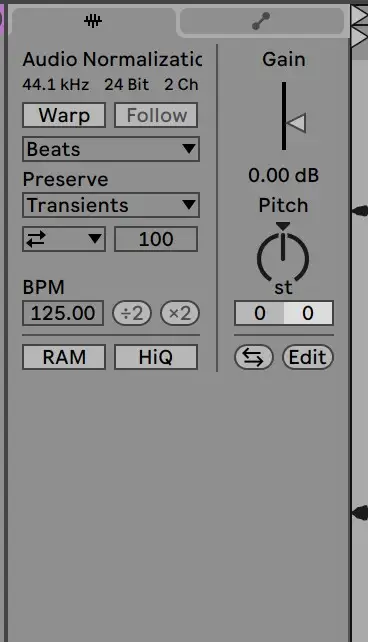

2. Wyłącz wypaczanie i zresetuj wzmocnienie do 0 dB

Następnie przejdź do klipu próbki, aby wyłączyć wypaczanie i zresetować wzmocnienie do 0 DB. Można to zrobić, klikając dwukrotnie strzałkę wzmocnienia:

3. Porównanie z oryginalnym plikiem

Od tego momentu klip powinien być znormalizowany! Możesz sprawdzić poziomy klipu w stosunku do oryginalnego pliku audio, aby upewnić się, że został on poprawnie przetworzony.

Normalizacja dźwięku jest niezbędną umiejętnością dla każdego producenta. Mamy nadzieję, że niniejszy przewodnik ułatwi ci dokładne zrozumienie, jak normalizować ścieżki i jak ważny jest ten proces.