Under de senaste tre decennierna har verkligheten för hur vi konsumerar musik helt förändrats. Med tillkomsten av DSP:er eller digitala streamingtjänster som Spotify och Apple Music har ljudnormalisering blivit en viktig del av processen.

Men vad innebär det att normalisera ljud? Och hur kan du normalisera dina egna digitala ljudfiler? Nedan berättar vi exakt hur man normaliserar ljud och varför det är ett viktigt steg i modernt musikskapande.

Vad är ljudnormalisering?

När du normaliserar ljud lägger du till en viss mängd förstärkning på en digital ljudfil. Detta gör att ljudfilen når en viss upplevd amplitud eller volymnivå samtidigt som spårens dynamiska omfång bevaras.

Ljudnormalisering används för att uppnå maximal volym från ett valt ljudklipp. Det kan också användas för att skapa mer enhetlighet mellan flera ljudklipp. Du kan t.ex. ha flera spår i ett album eller en EP.

Det är värt att notera att låtar med ett större dynamiskt omfång kan vara svårare att normalisera på ett effektivt sätt. En toppamplitud kan t.ex. bli mosad eller förvrängd genom normaliseringsprocessen.

Därför bör varje enskilt ljudklipp hanteras på olika sätt när det gäller normaliseringsprocessen. Ljudnormalisering är viktigt för alla digitala inspelningar, men det finns inte en metod som passar alla.

Varför bör du normalisera ljud?

Så varför är det viktigt att normalisera dina ljudfiler? Här är några scenarier där normalisering av loudness är ett måste:

Förberedelser för streamingtjänster

Streamingtjänsterna fastställer en standardiserad normaliseringsnivå för alla låtar som finns i deras musikbibliotek. På så sätt behöver lyssnarna inte skruva upp eller ner volymen drastiskt när de byter från en låt till en annan. Varje plattform har en annan målnivå, så det är inte ovanligt att ha olika mastrar för olika streamingplattformar.

LUFs Loudness-mål för de mest populära streamingtjänsterna är följande:

Spotify: -14 LUFS

Apple Music: -16 LUFS

Amazon Music: -9 till -13 LUFS

Youtube: -13 till -15 LUFS

Deezer: -14 till -16 LUFS

CD: -9 LUFS

Soundcloud: -8 till -13 LUFS

Varje ingenjör har sin egen filosofi när det gäller att bestämma målnivån för varje master, men dessa standardiseringar bör tas med i beräkningen.

Uppnå maximal volym

Ljudnormalisering kan användas för att uppnå maximal förstärkning av varje ljudfil. Detta kan vara mycket användbart vid import av spår till ljudredigeringsprogram eller för att göra en enskild ljudfil mer högljudd.

Skapa en konsekvent nivå mellan flera ljudfiler

Du kan också normalisera ljud för att ställa in flera ljudfiler på samma relativa nivå. Detta är särskilt viktigt i processer som gain staging, där du ställer in ljudnivåer som förberedelse för nästa steg i bearbetningen.

Du kan också normalisera och redigera ljudfiler när du har slutfört ett musikprojekt som ett album eller en EP. Hela inspelningsatmosfären och ljudet bör vara ganska konsekvent hela tiden, så du kanske måste gå tillbaka och justera förstärkningen i samband med alla låtar.

De två typerna av ljudnormalisering

Det finns olika typer av ljudnormalisering för olika användningsfall för ljudinspelning. För det mesta handlar normalisering av ljud om normalisering av toppar och normalisering av loudness.

Normalisering av toppar

Peak-normalisering är en linjär process där samma mängd förstärkning appliceras över en ljudsignal för att skapa en nivå som överensstämmer med ljudspårets toppamplitud. Det dynamiska omfånget förblir detsamma och den nya ljudfilen låter mer eller mindre likadant, förutom att spåret omvandlas till en mer högljudd eller tyst ljudfil.

Den här processen hittar det högsta PCM-värdet eller pulskodmoduleringsvärdet i en ljudfil. I grund och botten bearbetar peak-normaliseringen ljud baserat på den övre gränsen för ett digitalt ljudsystem, vilket vanligtvis motsvarar normalisering av max peak vid 0 DBs.

Normaliseringseffekten genom peak-normalisering är strikt baserad på peak-nivåer, snarare än den upplevda volymen på spåret.

Normalisering av ljudstyrka

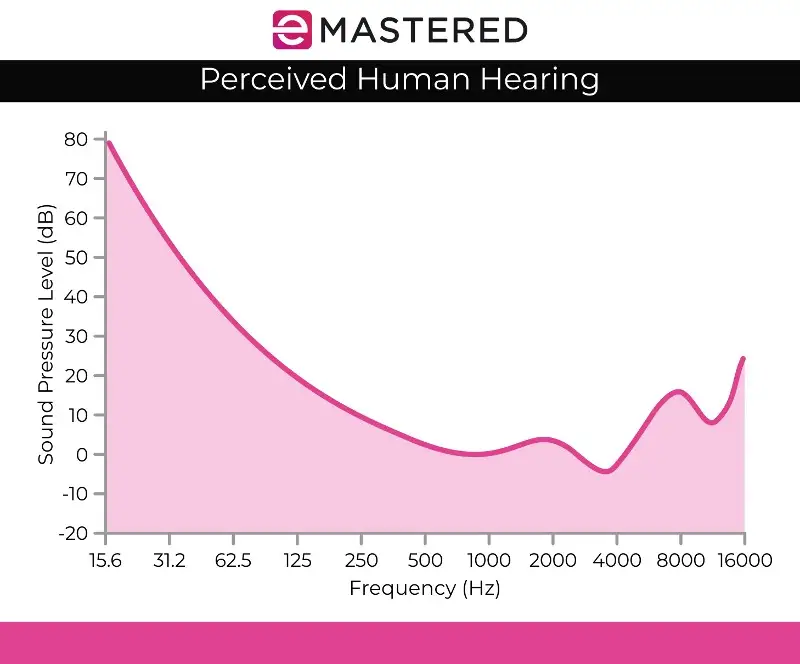

Normaliseringsprocessen för loudness är mer komplex eftersom den tar hänsyn till den mänskliga hörseluppfattningen. Den mänskliga hörseln tar hänsyn till olika volymer och amplituder separat eftersom det mänskliga örat har vissa subjektiva brister när det gäller perception. Du kan höra den här bearbetningen kallas EBU R 128 volymdetektering.

Exempelvis låter ljud som är ihållande på samma ljudnivå som ljud som spelas upp kortvarigt automatiskt högre. Du kan spela upp dessa ljud på samma volymnivå, men den mänskliga hörseln kommer ändå att uppfatta det ihållande ljudet som högre. Därför måste normaliseringen av ljudstyrkan ta hänsyn till dessa perceptuella skillnader.

Vissa tror också att högre musik tenderar att låta bättre. Det var detta som gav upphov till loudness-krigen innan streamingtjänsterna fanns, där musiker försökte maximera toppvolymen för att producera ett mer ljudmässigt tilltalande konstverk. Lyckligtvis har ljudnormalisering effektivt avslutat loudness-kriget, så att du inte ständigt hör olika volymer när du hoppar från ett spår till nästa.

Loudness-normalisering mäts i LUF, vilket är mer troget det mänskliga örat och fungerar som ljudstandarder i applikationer som film, TV, radio och streamingtjänster. Precis som vid peak-normalisering är 0 dB fortfarande standard.

Fletcher Munson-kurvan, som visas ovan, kan hjälpa till att beskriva de avvikelser som LUFS normalisering av ljudstyrka tar hänsyn till.

Detektering av RMS-volym

Om du inte ska normalisera stereokanaler med toppnivånormalisering kommer du sannolikt att använda loudness-normalisering, men det är ändå värt att nämna den andra metoden för loudness-bearbetning, som är RMS-volymdetektering.

Normaliseringsprocessen liknar LUF:s normalisering av loudness men den använder RMS-nivåer istället. Root Mean Square eller RMS mäter den genomsnittliga volymen för en sektion eller hela varaktigheten för ett klipp.

Men precis som normalisering baserad på den högsta toppen tar RMS-normalisering inte hänsyn till det mänskliga örat. Det är därför som masteringingenjörer vanligtvis arbetar med LUF:s loudness-enheter och normaliseringsprocesser som standard. Mastering handlar inte bara om att skapa matchande volymer genom hela projektet. Det är också viktigt att ta ett steg tillbaka och överväga dynamik, mänsklig uppfattning och balans mellan varje spår.

Normalisering kontra komprimering: Vad är skillnaden?

Många gånger tror man att normalisering och komprimering är samma sak, men det är en vanlig missuppfattning. Komprimering är utformad för att höja den lägsta volymen i ett spår och sänka topparna i ett spår, vilket skapar mer övergripande konsekventa volymnivåer. Normalisering däremot sätter den högsta ljudnivån som tak i ditt ljudspår.

Därefter appliceras en proportionell mängd clip gain på resten av ljudet, vilket bevarar dynamiken (avståndet mellan de högsta och lägsta ljuden) och effektivt höjer den upplevda volymen beroende på toppnivån.

Nackdelarna med ljudnormalisering

Det är värt att notera att det finns vissa nackdelar med ljudnormalisering. För det mesta normaliserar du bara ljud under de sista stadierna av skapandeprocessen. Detta beror på att normalisering ofta tar upp ljudet till toppamplituden inom ett digitalt tak, så du har inte mycket redigeringskraft efter att en ljudbit har normaliserats.

Du skulle inte vilja normalisera enskilda ljudspår som fortfarande behöver mixas inom ramen för en flerspårsinspelning. Om alla enskilda komponenter redan är normaliserade till ditt digitala ljudtak kommer de med största sannolikhet att klippas när de spelas upp tillsammans.

Ljudnormalisering är också destruktivt till sin natur. När du normaliserar ljudet bakas den digitala bearbetningen in i ljudspåret. Därför har ljudnormalisering en tydlig tid och plats. Denna process används oftast efter att dina ljudfiler har bearbetats till smak.

Hur man normaliserar ljud

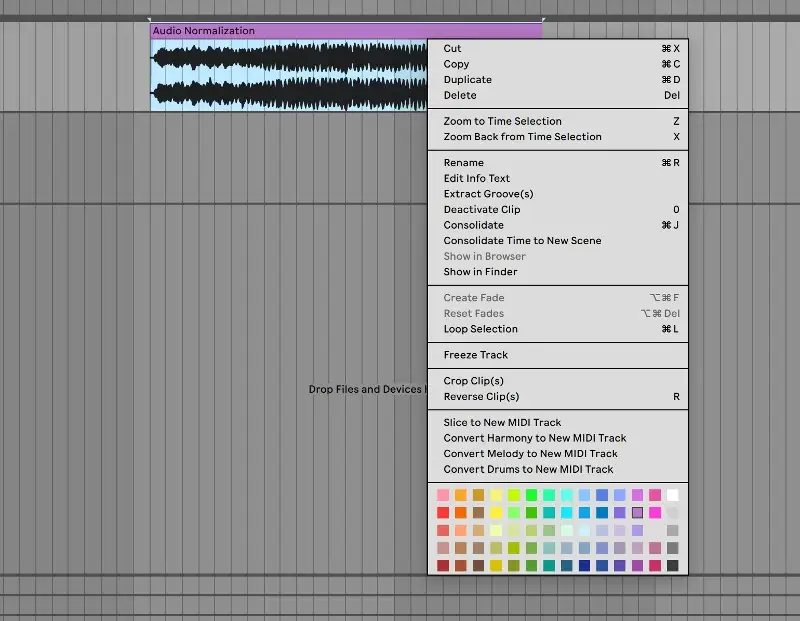

Varje DAW har sitt eget sätt att normalisera digitalt ljud. Vi visar hur du kan normalisera ljud i Ableton Live, men alla ljudredigeringsprogram har denna funktion inbyggd i sina kontroller:

1. Konsolidera dina spår

Börja med att föra över din ljudfil till ett rent ljudspår. Markera ljudspåret, högerklicka och välj "konsolidera" på menyn. Du kan också använda kortkommandot CTRL/CMND + J för att snabbt konsolidera ett markerat spår.

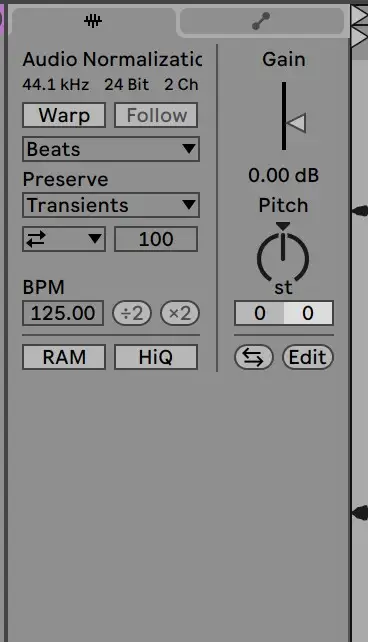

2. Inaktivera Warp och återställ förstärkningen till 0 dB

Gå sedan till provklippet för att inaktivera warp och återställa gain till 0 DB. Du kan göra detta genom att dubbelklicka på gain-pilen:

3. Kontrollera mot originalfilen

Därefter bör ditt klipp vara normaliserat! Du kan kontrollera klippets nivåer mot den ursprungliga ljudfilen för att se till att det har bearbetats korrekt.

Att normalisera ljud är en viktig färdighet för alla producenter. Förhoppningsvis gör den här guiden det lättare för dig att förstå exakt hur du normaliserar dina spår och hur viktig den här processen är.