In den letzten drei Jahrzehnten hat sich die Art und Weise, wie wir Musik konsumieren, völlig verändert. Mit dem Aufkommen von DSPs oder digitalen Streaming-Diensten wie Spotify und Apple Music ist die Audionormalisierung ein wesentlicher Bestandteil des Prozesses geworden.

Aber was bedeutet es, Audio zu normalisieren? Und wie können Sie Ihre eigenen digitalen Audiodateien normalisieren? Im Folgenden erklären wir Ihnen genau, wie man Audio normalisiert und warum dies ein wichtiger Schritt beim modernen Musikmachen ist.

Was ist Audio-Normalisierung?

Bei der Normalisierung von Audiodaten wird eine digitale Audiodatei um einen bestimmten Betrag verstärkt. Dadurch wird die Audiodatei auf einen bestimmten wahrgenommenen Amplituden- oder Lautstärkepegel gebracht, während der Dynamikbereich der Tracks erhalten bleibt.

Die Audionormalisierung wird verwendet, um die maximale Lautstärke eines ausgewählten Audioclips zu erreichen. Sie kann auch verwendet werden, um mehr Konsistenz über mehrere Audioclips hinweg zu schaffen. Zum Beispiel können Sie mehrere Tracks innerhalb eines Albums oder einer EP haben.

Es ist erwähnenswert, dass Songs mit einem größeren Dynamikbereich schwieriger zu normalisieren sein können. Zum Beispiel kann eine Spitzenamplitude durch den Normalisierungsprozess gequetscht oder verzerrt werden.

Daher sollte jeder einzelne Audioclip bei der Normalisierung anders behandelt werden. Die Normalisierung von Audiodaten ist für jede digitale Aufnahme unerlässlich, aber es gibt keinen einheitlichen Ansatz für alle.

Warum sollten Sie Audio normalisieren?

Warum ist es also wichtig, Ihre Audiodateien zu normalisieren? Hier sind einige Szenarien, in denen Lautheitsnormalisierung ein Muss ist:

Vorbereitung für Streaming-Dienste

Streaming-Dienste legen einen Standard-Normalisierungspegel für alle in ihren Musikbibliotheken gespeicherten Titel fest. Auf diese Weise müssen die Hörer die Lautstärke nicht drastisch hoch- oder runterdrehen, wenn sie von einem Lied zum anderen wechseln. Jede Plattform hat einen anderen Zielpegel, so dass es nicht ungewöhnlich ist, verschiedene Master für verschiedene Streaming-Plattformen zu haben.

Die LUFs-Loudness-Ziele für die beliebtesten Streaming-Dienste lauten wie folgt:

Spotify: -14 LUFS

Apple Music: -16 LUFS

Amazon Music: -9 bis -13 LUFS

Youtube: -13 bis -15 LUFS

Deezer: -14 bis -16 LUFS

CD: -9 LUFS

Soundcloud: -8 bis -13 LUFS

Jeder Ingenieur hat seine eigene Philosophie, wenn es um die Bestimmung des Zielniveaus für jeden Master geht, aber diese Standardisierungen sollten berücksichtigt werden.

Erreichen des maximalen Volumens

Die Audionormalisierung kann verwendet werden, um die maximale Verstärkung jeder Audiodatei zu erreichen. Dies kann beim Importieren von Tracks in eine Audiobearbeitungssoftware sehr nützlich sein, oder um eine einzelne Audiodatei lauter zu machen.

Einen konsistenten Pegel zwischen mehreren Audiodateien erzeugen

Sie können Audio auch normalisieren, um mehrere Audiodateien auf denselben relativen Pegel einzustellen. Dies ist besonders wichtig bei Prozessen wie Gain Staging, bei denen Sie Audiopegel als Vorbereitung für die nächste Verarbeitungsstufe festlegen.

Sie können Audiodateien auch normalisieren und bearbeiten, wenn Sie ein Musikprojekt wie ein Album oder eine EP fertiggestellt haben. Die Atmosphäre und der Klang der gesamten Aufnahme sollten ziemlich einheitlich sein, sodass Sie eventuell zurückgehen und die Verstärkung im Kontext aller Songs anpassen müssen.

Die zwei Arten der Audio-Normalisierung

Es gibt verschiedene Arten der Audionormalisierung für verschiedene Anwendungsfälle der Audioaufnahme. Meistens läuft die Normalisierung von Audio auf die Normalisierung von Spitzenwerten und Lautheit hinaus.

Spitzenwert-Normalisierung

Die Spitzenwertnormalisierung ist ein linearer Prozess, bei dem der gleiche Verstärkungsgrad auf ein Audiosignal angewendet wird, um einen Pegel zu erzeugen, der mit der Spitzenwertamplitude der Audiospur übereinstimmt. Der Dynamikbereich bleibt gleich, und die neue Audiodatei klingt mehr oder weniger gleich, abgesehen davon, dass sich die Spur in eine lautere oder leisere Audiodatei verwandelt.

Bei diesem Verfahren wird der höchste PCM-Wert oder Pulscodemodulationswert einer Audiodatei ermittelt. Grundsätzlich verarbeitet die Peak-Normalisierung Audiodaten auf der Grundlage der Obergrenze eines digitalen Audiosystems, was in der Regel einer Normalisierung von Max Peak auf 0 DBs entspricht.

Der Normalisierungseffekt durch die Spitzenwertnormalisierung basiert ausschließlich auf Spitzenpegeln und nicht auf der wahrgenommenen Lautstärke des Tracks.

Loudness-Normalisierung

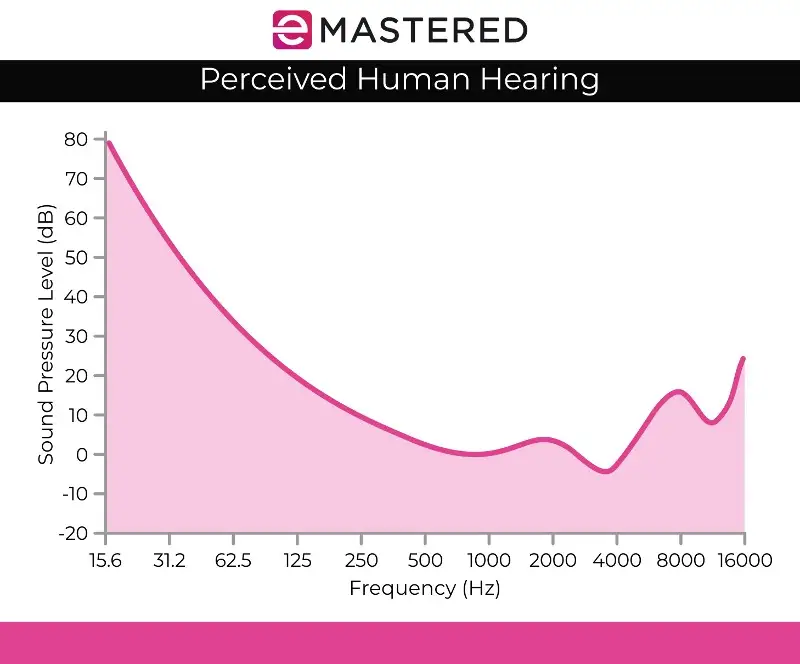

Der Prozess der Lautheitsnormalisierung ist komplexer, da er die menschliche Wahrnehmung des Gehörs mit einbezieht. Das menschliche Gehör berücksichtigt unterschiedliche Lautstärken und Amplituden separat, da das menschliche Ohr bestimmte subjektive Wahrnehmungsfehler aufweist. Diese Verarbeitung wird auch als EBU R 128-Lautstärkeerkennung bezeichnet.

So klingen z. B. Töne, die mit demselben Lautstärkepegel gehalten werden wie Töne, die nur kurz oder kurz abgespielt werden, automatisch lauter. Man kann diese Töne mit demselben Lautstärkepegel ausgeben, und das menschliche Gehör würde den anhaltenden Ton dennoch als lauter wahrnehmen. Daher muss die Lautheitsnormalisierung diese Wahrnehmungsabweichungen berücksichtigen.

Manche glauben auch, dass lautere Musik tendenziell besser klingt. Das war die Ursache für die Lautstärkekriege, bevor es Streamingdienste gab, bei denen Musiker versuchten, die maximale Lautstärke zu erreichen, um ein klanglich ansprechendes Kunstwerk zu produzieren. Glücklicherweise hat die Audionormalisierung den Lautheitskrieg beendet, so dass man nicht ständig unterschiedliche Lautstärken hört, wenn man von einem Titel zum nächsten springt.

Die Lautheitsnormalisierung wird in LUFs gemessen, was dem menschlichen Gehör besser entspricht und als Audiostandard in Anwendungen wie Film, Fernsehen, Radio und Streaming-Diensten dient. Genau wie bei der Spitzenwertnormalisierung bleiben 0 dB der Standard.

Die oben dargestellte Fletcher-Munson-Kurve kann helfen, die Diskrepanzen zu beschreiben, die bei der LUFS-Lautheitsnormalisierung berücksichtigt werden.

RMS-Lautstärke-Erkennung

Wenn Sie Stereokanäle nicht mit der Spitzenpegel-Normalisierung normalisieren wollen, werden Sie wahrscheinlich die Lautheitsnormalisierung verwenden, aber es lohnt sich trotzdem, die andere Methode der Lautheitsverarbeitung zu erwähnen, nämlich die RMS-Lautstärkeerkennung.

Der Prozess der Normalisierung ähnelt der LUF-Lautheitsnormalisierung, verwendet aber stattdessen RMS-Pegel. Root Mean Square oder RMS misst die durchschnittliche Lautstärke eines Abschnitts oder der gesamten Dauer eines Clips.

Genau wie die Normalisierung auf der Grundlage des höchsten Peaks berücksichtigt die RMS-Normalisierung jedoch nicht das menschliche Gehör. Aus diesem Grund arbeiten Mastering-Ingenieure in der Regel mit LUFs-Lautstärkeeinheiten und Normalisierungsprozessen als Standard. Beim Mastering geht es nicht nur darum, für das gesamte Projekt die passende Lautstärke zu finden. Es ist auch wichtig, einen Schritt zurückzutreten und die Dynamik, die menschliche Wahrnehmung und die Balance zwischen den einzelnen Tracks zu berücksichtigen.

Normalisierung vs. Komprimierung: Was ist der Unterschied?

Oft wird angenommen, dass Normalisierung und Komprimierung dasselbe sind, aber das ist ein weit verbreiteter Irrtum. Die Komprimierung dient dazu, die niedrigste Lautstärke eines Tracks anzuheben und die Spitzenwerte eines Tracks abzusenken, um insgesamt einheitlichere Lautstärkepegel zu schaffen. Im Gegensatz dazu wird bei der Normalisierung der lauteste Punkt als Höchstwert in der Audiospur festgelegt.

Von dort aus wird ein proportionaler Anteil der Clip-Verstärkung auf den Rest des Audiosignals angewendet, wobei die Dynamik (der Abstand zwischen den lautesten und den leisesten Tönen) erhalten bleibt und die wahrgenommene Lautstärke je nach Spitzenpegel effektiv erhöht wird.

Die Nachteile der Audio-Normalisierung

Es ist erwähnenswert, dass die Audionormalisierung auch einige Nachteile mit sich bringt. Meistens werden die Audiodaten erst in den letzten Phasen des Erstellungsprozesses normalisiert. Das liegt daran, dass durch die Normalisierung oft die Spitzenamplitude innerhalb einer digitalen Obergrenze erreicht wird, sodass Sie nach der Normalisierung eines Audiomaterials nicht mehr viel Bearbeitungsmöglichkeiten haben.

Sie sollten keine einzelnen Audiospuren normalisieren, die im Rahmen einer Mehrspuraufnahme noch gemischt werden müssen. Wenn alle einzelnen Komponenten bereits auf Ihre digitale Audio-Decke normalisiert sind, werden sie bei der gemeinsamen Wiedergabe mit Sicherheit übersteuert.

Auch die Normalisierung von Audiodaten ist von Natur aus destruktiv. Bei der Normalisierung von Audiodaten wird die digitale Verarbeitung in die Audiospur eingebrannt. Daher gibt es für die Audionormalisierung eine klare Zeit und einen klaren Ort. Dieser Prozess wird meist angewendet, nachdem Ihre Audiodateien nach Belieben bearbeitet wurden.

Wie man Audio normalisiert

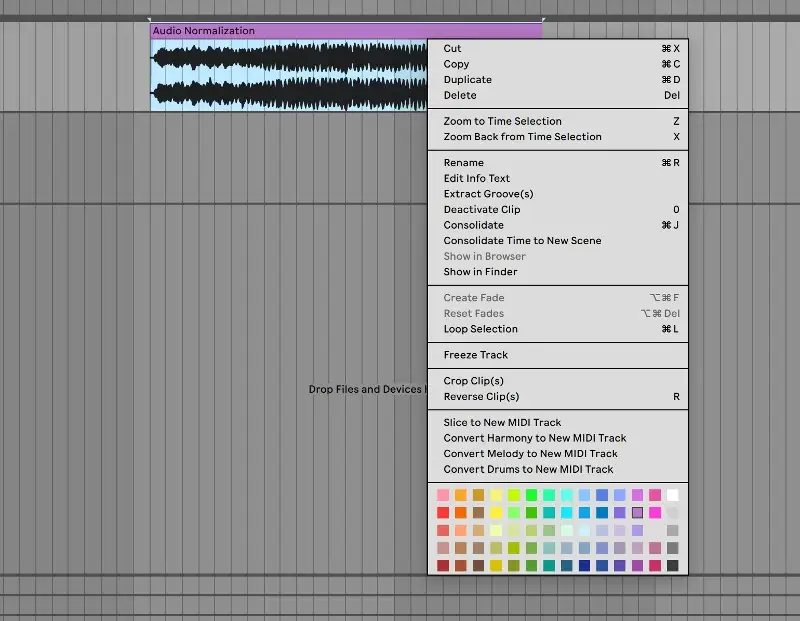

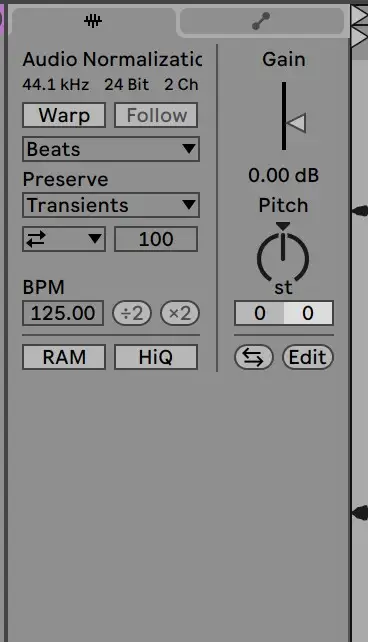

Jede DAW hat ihre eigene Methode, digitales Audiomaterial zu normalisieren. Wir zeigen Ihnen, wie Sie Audio in Ableton Live normalisieren können, aber alle Audiobearbeitungsprogramme haben diese Funktion in ihre Bedienelemente integriert:

1. Konsolidieren Sie Ihren Track

Bringen Sie Ihre Audiodatei zunächst auf eine saubere Audiospur. Wählen Sie die Audiospur aus, klicken Sie mit der rechten Maustaste und wählen Sie "Konsolidieren" aus dem Menü. Sie können auch das Tastaturkürzel STRG/CMND + J verwenden, um eine markierte Spur schnell zu konsolidieren.

2. Warp deaktivieren und Verstärkung auf 0 dB zurücksetzen

Gehen Sie von dort aus zum Sample-Clip, um Warp zu deaktivieren und die Verstärkung auf 0 DB zurückzusetzen. Sie können dies tun, indem Sie auf den Verstärkungspfeil doppelklicken:

3. Abgleich mit der Originaldatei

Danach sollte Ihr Clip normalisiert sein! Sie können die Pegel Ihres Clips mit denen der Original-Audiodatei vergleichen, um sicherzustellen, dass er korrekt verarbeitet wurde.

Die Normalisierung von Audiomaterial ist eine wichtige Fähigkeit für jeden Produzenten. Wir hoffen, dass dieser Leitfaden es Ihnen leichter macht, genau zu verstehen, wie Sie Ihre Spuren normalisieren und wie wichtig dieser Prozess ist.