En las últimas tres décadas, la realidad de cómo consumimos música ha cambiado por completo. Con la llegada de los DSP o los servicios de streaming digital como Spotify y Apple Music, la normalización del audio se ha convertido en una parte esencial del proceso.

Pero, ¿qué significa normalizar el audio? ¿Y cómo puedes normalizar tus propios archivos de audio digital? A continuación te explicamos exactamente cómo normalizar el audio y por qué es un paso clave en la creación musical moderna.

¿Qué es la normalización de audio?

Cuando normalizas audio, estás aplicando una cierta cantidad de ganancia a un archivo de audio digital. De este modo, el archivo de audio alcanza un nivel de amplitud o volumen percibido objetivo, conservando al mismo tiempo el rango dinámico de las pistas.

La normalización de audio se utiliza para conseguir el máximo volumen de un clip de audio seleccionado. También se puede utilizar para crear más coherencia entre varios clips de audio. Por ejemplo, puedes tener varias pistas dentro de un álbum o EP.

Hay que tener en cuenta que las canciones con un mayor rango dinámico pueden ser más difíciles de normalizar con eficacia. Por ejemplo, un pico de amplitud puede quedar aplastado o distorsionado durante el proceso de normalización.

Por lo tanto, cada clip de audio debe abordarse de forma diferente en lo que respecta al proceso de normalización. La normalización de audio es esencial para cualquier grabación digital, pero no existe un enfoque único.

¿Por qué hay que normalizar el audio?

¿Por qué es importante normalizar los archivos de audio? He aquí algunos casos en los que la normalización de la sonoridad es imprescindible:

Preparación para los servicios de streaming

Los servicios de streaming establecen un nivel de normalización estándar en todas las canciones alojadas en sus bibliotecas musicales. De este modo, los oyentes no tendrán que subir o bajar drásticamente el volumen al pasar de una canción a otra. Cada plataforma tiene un nivel de normalización diferente, por lo que no es raro tener diferentes masters para varias plataformas de streaming.

Los objetivos de sonoridad LUFs para los servicios de streaming más populares son los siguientes:

Spotify: -14 LUFS

Apple Music: -16 LUFS

Amazon Music: -9 a -13 LUFS

Youtube: -13 a -15 LUFS

Deezer: -14 a -16 LUFS

CD: -9 LUFS

Soundcloud: -8 a -13 LUFS

Cada ingeniero tiene su propia filosofía a la hora de determinar el nivel objetivo para cada maestro, pero hay que tener en cuenta estas normalizaciones.

Alcanzar el máximo volumen

La normalización de audio se puede utilizar para conseguir la máxima ganancia de cada archivo de audio. Esto puede ser increíblemente útil al importar pistas a un software de edición de audio o para hacer más fuerte un archivo de audio individual.

Crear un nivel coherente entre varios archivos de audio

También puedes normalizar audio para ajustar varios archivos de audio al mismo nivel relativo. Esto es especialmente importante en procesos como el escalonamiento de ganancia, en el que se fijan los niveles de audio como preparación para la siguiente fase de procesamiento.

También puedes normalizar y editar archivos de audio al terminar un proyecto musical como un álbum o un EP. La atmósfera y el sonido de toda la grabación deben ser bastante homogéneos, por lo que es posible que tengas que volver atrás y ajustar la ganancia en el contexto de todas las canciones.

Los dos tipos de normalización de audio

Existen diferentes tipos de normalización de audio para diversos casos de uso de grabación de audio. La mayoría de las veces, la normalización de audio se reduce a la normalización de picos y la normalización de volumen.

Normalización de picos

La normalización de picos es un proceso lineal en el que se aplica la misma cantidad de ganancia a una señal de audio para crear un nivel coherente con la amplitud de pico de la pista de audio. El rango dinámico sigue siendo el mismo, y el nuevo archivo de audio suena más o menos igual sin que la pista se transforme en un archivo de audio más alto o más bajo.

Este proceso encuentra el valor PCM o de modulación por impulsos codificados más alto de un archivo de audio. Básicamente, la normalización de picos procesa el audio basándose en el límite superior de un sistema de audio digital, lo que suele equivaler a normalizar el pico máximo a 0 DBs.

El efecto de normalización a través de la normalización de picos se basa estrictamente en los niveles de pico, en lugar del volumen percibido de la pista.

Normalización del volumen

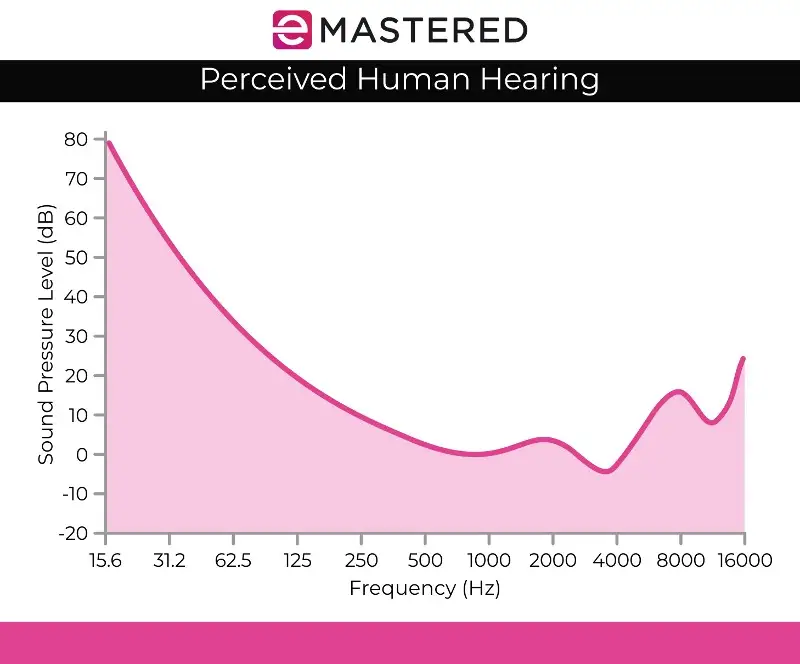

El proceso de normalización del volumen es más complejo, ya que tiene en cuenta la percepción humana de la audición. La audición humana tiene en cuenta los diferentes volúmenes y amplitudes por separado, ya que el oído humano tiene ciertos defectos subjetivos en lo que se refiere a la percepción. Es posible que este proceso se denomine detección de volumen EBU R 128.

Por ejemplo, los sonidos que se mantienen al mismo nivel de audio que los que se reproducen de forma transitoria o breve suenan automáticamente más altos. Se pueden emitir estos sonidos al mismo nivel de volumen, y el oído humano seguirá percibiendo el sonido sostenido como más alto. Por lo tanto, la normalización de la sonoridad debe tener en cuenta estas desviaciones perceptivas.

También hay quien cree que la música más alta suele sonar mejor. Esto es lo que dio lugar a las guerras de volumen antes de que existieran los servicios de streaming, en las que los músicos intentaban maximizar el volumen máximo para producir una obra de arte sonoramente más agradable. Afortunadamente, la normalización del audio ha puesto fin a la guerra del volumen, de modo que ya no se oyen constantemente volúmenes diferentes al pasar de una pista a otra.

La normalización de la sonoridad se mide en LUF, que es más fiel al oído humano y sirve como estándar de audio en aplicaciones como el cine, la televisión, la radio y los servicios de streaming. Al igual que la normalización de picos, 0 dB sigue siendo el estándar.

La curva de Fletcher Munson, representada anteriormente, puede ayudar a describir las discrepancias que se tienen en cuenta con la normalización de sonoridad LUFS.

Detección de volumen RMS

Si no vas a normalizar los canales estéreo con la normalización de nivel de pico, es probable que utilices la normalización de sonoridad, pero aún así merece la pena mencionar el otro método de procesamiento de sonoridad, que es la detección de volumen RMS.

El proceso de normalización es similar a la normalización de sonoridad de LUF, pero utiliza niveles RMS en su lugar. La raíz cuadrada media o RMS mide el volumen medio de una sección o de toda la duración de un clip.

Sin embargo, al igual que la normalización basada en el pico más alto, la normalización RMS no tiene en cuenta el oído humano. Por eso, los ingenieros de masterización suelen trabajar con unidades de sonoridad LUF y procesos de normalización como estándar. La masterización no consiste sólo en crear volúmenes que coincidan en todo el proyecto. También es fundamental dar un paso atrás y tener en cuenta la dinámica, la percepción humana y el equilibrio entre cada pista.

Normalización frente a compresión: ¿Cuál es la diferencia?

Muchas veces se piensa que la normalización y la compresión son lo mismo, pero se trata de un error muy común. La compresión está diseñada para subir el volumen más bajo de una pista y bajar los picos de una pista, creando niveles de volumen más consistentes en general. Por el contrario, la normalización establece el punto más alto como el techo de la pista de audio.

A partir de ahí, se aplica una cantidad proporcional de ganancia de clip al resto del audio, preservando la dinámica (la distancia entre los sonidos más altos y más bajos), subiendo efectivamente el volumen percibido en función del nivel de pico.

Los inconvenientes de la normalización de audio

Vale la pena señalar que la normalización del audio tiene algunas desventajas. La mayoría de las veces, sólo se normaliza el audio durante las etapas finales del proceso de creación. Esto se debe a que la normalización a menudo lleva el audio hasta el pico de amplitud dentro de un techo digital, por lo que no tienes mucho poder de edición después de que una pieza de audio ha sido normalizada.

No querrás normalizar pistas de audio individuales que aún deben mezclarse en el contexto de una grabación multipista. Si todos los componentes individuales ya están normalizados a su techo de audio digital, lo más seguro es que se recorten cuando se reproduzcan juntos.

La normalización del audio también es destructiva por naturaleza. Al normalizar el audio, el procesamiento digital se incorpora a la pista de audio. Por lo tanto, la normalización de audio tiene un momento y un lugar claros. Este proceso se utiliza sobre todo después de haber procesado los archivos de audio al gusto.

Cómo normalizar el audio

Cada DAW tiene su propia forma de normalizar el audio digital. Vamos a mostrar cómo se puede normalizar el audio en Ableton Live, pero todo el software de edición de audio tiene esta capacidad incorporada en sus controles:

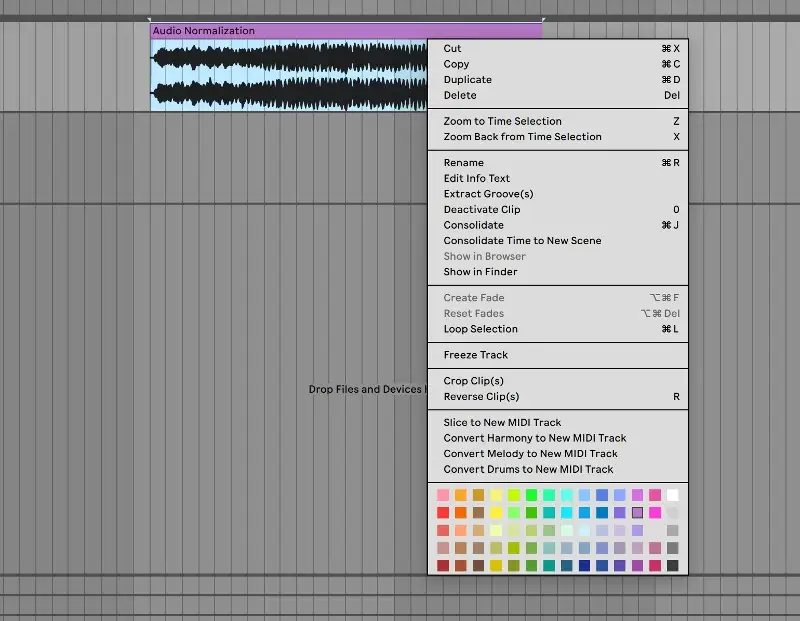

1. Consolide su pista

Para empezar, lleva tu archivo de audio a una pista de audio limpia. Selecciona la pista de audio, haz clic con el botón derecho y selecciona "consolidar" en el menú. También puedes utilizar el atajo de teclado CTRL/CMND + J para consolidar rápidamente una pista resaltada.

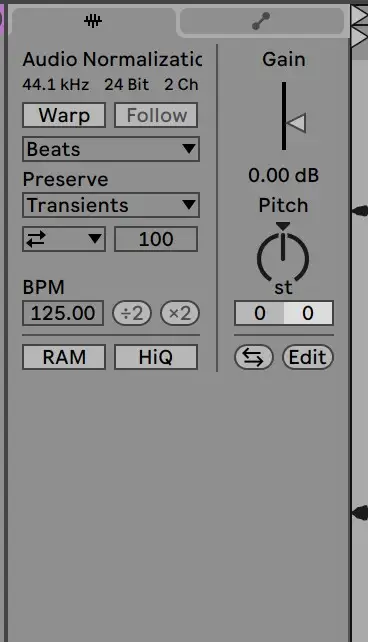

2. Desactivar Warp y Restablecer Ganancia a 0 dB

Desde ahí, ve al clip de muestra para desactivar el warp y restablecer la ganancia a 0 DB. Para ello, haz doble clic en la flecha de ganancia:

3. Comparación con el archivo original

A partir de ahí, ¡tu clip debería estar normalizado! Puedes comparar los niveles del clip con los del archivo de audio original para asegurarte de que se ha procesado correctamente.

Normalizar el audio es una habilidad esencial para cualquier productor. Esperamos que esta guía te ayude a entender exactamente cómo normalizar tus pistas y la importancia de este proceso.