Negli ultimi tre decenni, la realtà del consumo di musica è cambiata completamente. Con l'avvento dei DSP o dei servizi di streaming digitale come Spotify e Apple Music, la normalizzazione dell'audio è diventata una parte essenziale del processo.

Ma cosa significa normalizzare l'audio? E come si possono normalizzare i propri file audio digitali? Qui di seguito vi spieghiamo esattamente come normalizzare l'audio e perché è un passo fondamentale nella creazione di musica moderna.

Che cos'è la normalizzazione audio?

Quando si normalizza l'audio, si applica una certa quantità di guadagno a un file audio digitale. In questo modo si porta il file audio a un'ampiezza o a un livello di volume percepito, preservando la gamma dinamica delle tracce.

La normalizzazione audio viene utilizzata per ottenere il massimo volume da una clip audio selezionata. Può anche essere usata per creare una maggiore coerenza tra più clip audio. Ad esempio, si possono avere più tracce all'interno di un album o di un EP.

Vale la pena notare che i brani con una gamma dinamica più ampia possono essere più difficili da normalizzare in modo efficace. Ad esempio, l'ampiezza di un picco potrebbe risultare schiacciata o distorta durante il processo di normalizzazione.

Pertanto, ogni singolo clip audio deve essere affrontato in modo diverso quando si tratta del processo di normalizzazione. La normalizzazione dell'audio è essenziale per qualsiasi registrazione digitale, ma non esiste un approccio unico per tutti.

Perché normalizzare l'audio?

Perché è importante normalizzare i file audio? Ecco alcuni scenari in cui la normalizzazione del volume è indispensabile:

Preparazione per i servizi di streaming

I servizi di streaming stabiliscono un livello di normalizzazione standard per i brani ospitati nelle loro librerie musicali. In questo modo, gli ascoltatori non dovranno alzare o abbassare drasticamente il volume quando passano da un brano all'altro. Ogni piattaforma ha un livello di normalizzazione diverso, quindi non è raro avere master diversi per le varie piattaforme di streaming.

Gli obiettivi di loudness LUFs per i servizi di streaming più diffusi sono i seguenti:

Spotify: -14 LUFS

Apple Music: -16 LUFS

Amazon Music: da -9 a -13 LUFS

Youtube: da -13 a -15 LUFS

Deezer: da -14 a -16 LUFS

CD: -9 LUFS

Soundcloud: da -8 a -13 LUFS

Ogni ingegnere ha la propria filosofia quando si tratta di determinare il livello target per ogni master, ma è necessario tenere conto di queste standardizzazioni.

Raggiungere il massimo volume

La normalizzazione audio può essere utilizzata per ottenere il massimo guadagno di ciascun file audio. Ciò può essere incredibilmente utile durante l'importazione di tracce in software di editing audio o per rendere più forte un singolo file audio.

Creare un livello coerente tra diversi file audio

È anche possibile normalizzare l'audio per impostare più file audio allo stesso livello relativo. Questo è particolarmente essenziale in processi come il gain staging, in cui si impostano i livelli audio in preparazione della fase successiva di elaborazione.

È inoltre possibile normalizzare e modificare i file audio al termine di un progetto musicale come un album o un EP. L'atmosfera e il suono dell'intera registrazione dovrebbero essere abbastanza coerenti, quindi potrebbe essere necessario tornare indietro e regolare il guadagno nel contesto di tutti i brani.

I due tipi di normalizzazione audio

Esistono diversi tipi di normalizzazione audio per vari casi di utilizzo della registrazione audio. Nella maggior parte dei casi, la normalizzazione dell'audio si riduce alla normalizzazione dei picchi e alla normalizzazione del volume.

Normalizzazione dei picchi

La normalizzazione dei picchi è un processo lineare in cui la stessa quantità di guadagno viene applicata a un segnale audio per creare un livello coerente con l'ampiezza di picco della traccia audio. La gamma dinamica rimane invariata e il nuovo file audio ha più o meno lo stesso suono, a parte la trasformazione della traccia in un file audio più forte o più silenzioso.

Questo processo individua il valore PCM o il valore di modulazione a codice di impulsi più alto di un file audio. In pratica, la normalizzazione del picco elabora l'audio in base al limite superiore di un sistema audio digitale, che di solito equivale a normalizzare il picco massimo a 0 DB.

L'effetto di normalizzazione attraverso la normalizzazione dei picchi si basa rigorosamente sui livelli di picco, piuttosto che sul volume percepito della traccia.

Normalizzazione del loudness

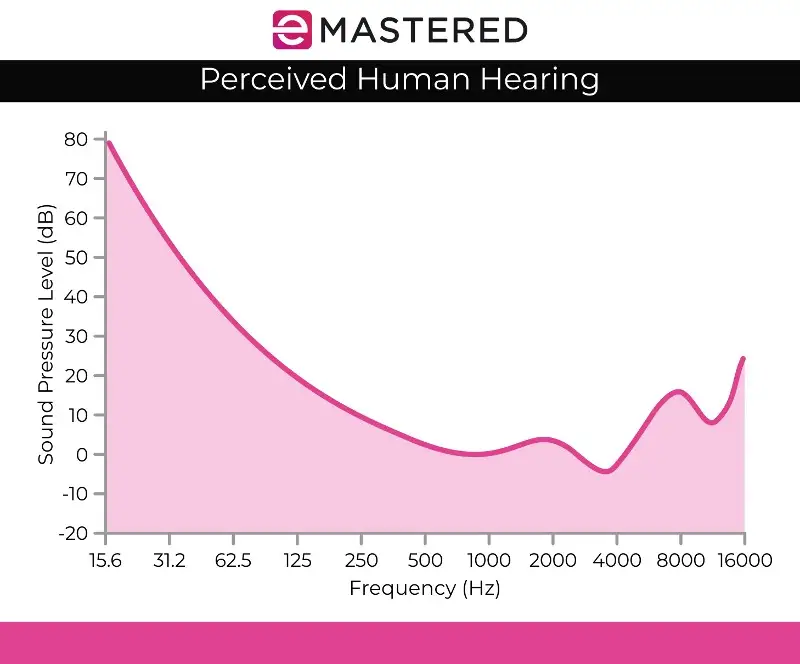

Il processo di normalizzazione del volume è più complesso perché tiene conto della percezione umana dell'udito. L'udito umano tiene conto dei diversi volumi e ampiezze separatamente, poiché l'orecchio umano ha alcuni difetti soggettivi quando si tratta di percezione. Si potrebbe sentire questa elaborazione come rilevamento del volume EBU R 128.

Ad esempio, i suoni sostenuti allo stesso livello audio di quelli riprodotti in modo transitorio o breve suonano automaticamente più forti. È possibile emettere questi suoni allo stesso livello di volume e l'udito umano continuerà a percepire il suono sostenuto come più forte. Di conseguenza, la normalizzazione del volume deve tenere conto di queste differenze percettive.

Alcuni credono anche che la musica più forte tenda a suonare meglio. Questo è ciò che ha dato vita alle guerre del volume prima dell'esistenza dei servizi di streaming, in cui i musicisti cercavano di massimizzare il volume di picco per produrre un'opera d'arte più gradevole dal punto di vista sonoro. Fortunatamente, la normalizzazione dell'audio ha posto fine alla guerra del volume, evitando di sentire continuamente volumi diversi quando si passa da un brano all'altro.

La normalizzazione del loudness si misura in LUF, che è più fedele all'orecchio umano e serve come standard audio in applicazioni come film, TV, radio e servizi di streaming. Come per la normalizzazione dei picchi, 0 dB rimangono lo standard.

La curva di Fletcher Munson, come illustrata sopra, può aiutare a descrivere le discrepanze prese in considerazione con la normalizzazione del volume LUFS.

Rilevamento del volume RMS

Se non si intende normalizzare i canali stereo con la normalizzazione del livello di picco, è probabile che si utilizzi la normalizzazione del volume, ma vale comunque la pena di menzionare l'altro metodo di elaborazione del volume, ovvero il rilevamento del volume RMS.

Il processo di normalizzazione è simile alla normalizzazione del loudness di LUF, ma utilizza i livelli RMS. Il Root Mean Square o RMS misura il volume medio di una sezione o dell'intera durata di un clip.

Tuttavia, proprio come la normalizzazione basata sul picco più alto, la normalizzazione RMS non tiene conto dell'orecchio umano. Per questo motivo gli ingegneri di mastering lavorano in genere con le unità di loudness e i processi di normalizzazione LUF come standard. Il mastering non si limita a creare volumi corrispondenti all'interno di un progetto. È fondamentale anche fare un passo indietro e considerare la dinamica, la percezione umana e l'equilibrio tra le singole tracce.

Normalizzazione e compressione: Qual è la differenza?

Spesso si pensa che normalizzazione e compressione siano la stessa cosa, ma si tratta di un'idea sbagliata. La compressione è progettata per aumentare il volume più basso di una traccia e abbassare i picchi di una traccia, creando livelli di volume complessivamente più coerenti. Al contrario, la normalizzazione imposta il punto di massimo volume nella traccia audio.

Da qui, una quantità proporzionale di guadagno del clip viene applicata al resto dell'audio, preservando la dinamica (la distanza tra i suoni più forti e quelli più deboli), aumentando di fatto il volume percepito a seconda del livello di picco.

Gli aspetti negativi della normalizzazione audio

Vale la pena di notare che la normalizzazione dell'audio presenta alcuni aspetti negativi. Nella maggior parte dei casi, la normalizzazione dell'audio avviene solo durante le fasi finali del processo di creazione. Questo perché la normalizzazione spesso porta l'audio all'ampiezza di picco all'interno di un soffitto digitale, quindi non si ha molto potere di editing dopo che un pezzo di audio è stato normalizzato.

Non è il caso di normalizzare singole tracce audio che devono ancora essere mixate nel contesto di una registrazione multitraccia. Se tutti i singoli componenti sono già normalizzati rispetto al soffitto dell'audio digitale, quando vengono riprodotti insieme, sicuramente si interromperanno.

Anche la normalizzazione audio è distruttiva per natura. Quando si normalizza l'audio, l'elaborazione digitale viene incorporata nella traccia audio. Pertanto, la normalizzazione audio ha un tempo e un luogo ben precisi. Questo processo viene utilizzato soprattutto dopo che i file audio sono stati elaborati a piacimento.

Come normalizzare l'audio

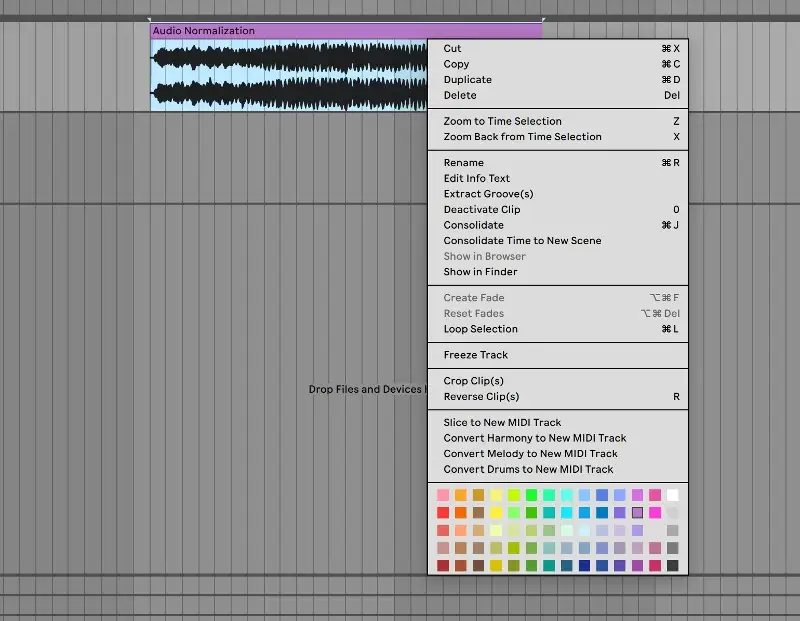

Ogni DAW ha il proprio modo di normalizzare l'audio digitale. Mostreremo come si può normalizzare l'audio in Ableton Live, ma tutti i software di editing audio hanno questa capacità nei loro controlli:

1. Consolidare la traccia

Per iniziare, portare il file audio in una traccia audio pulita. Selezionare la traccia audio, fare clic con il tasto destro del mouse e selezionare "consolida" dal menu. È anche possibile utilizzare la scorciatoia da tastiera CTRL/CMND + J per consolidare rapidamente una traccia evidenziata.

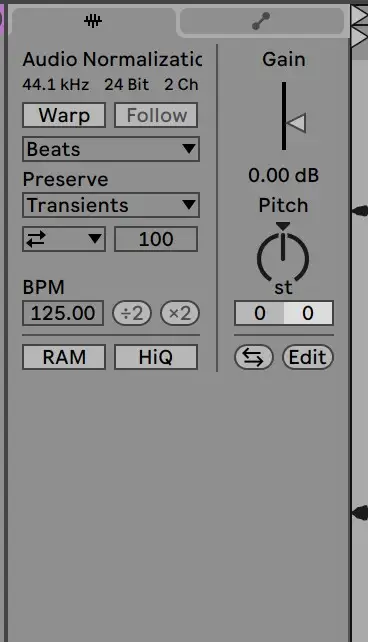

2. Disattivare la deformazione e ripristinare il guadagno a 0 dB.

Da qui, passare al clip campione per disabilitare la deformazione e reimpostare il guadagno a 0 DB. È possibile farlo facendo doppio clic sulla freccia del guadagno:

3. Verifica con il file originale

Da qui, il clip dovrebbe essere normalizzato! È possibile verificare i livelli del clip rispetto al file audio originale per assicurarsi che sia stato elaborato correttamente.

La normalizzazione dell'audio è un'abilità essenziale per qualsiasi produttore. Speriamo che questa guida faciliti la comprensione di come normalizzare le tracce e dell'importanza di questo processo.